Как я полюбил Midjourney и теперь делаю картинки, которые расходятся по всему интернету

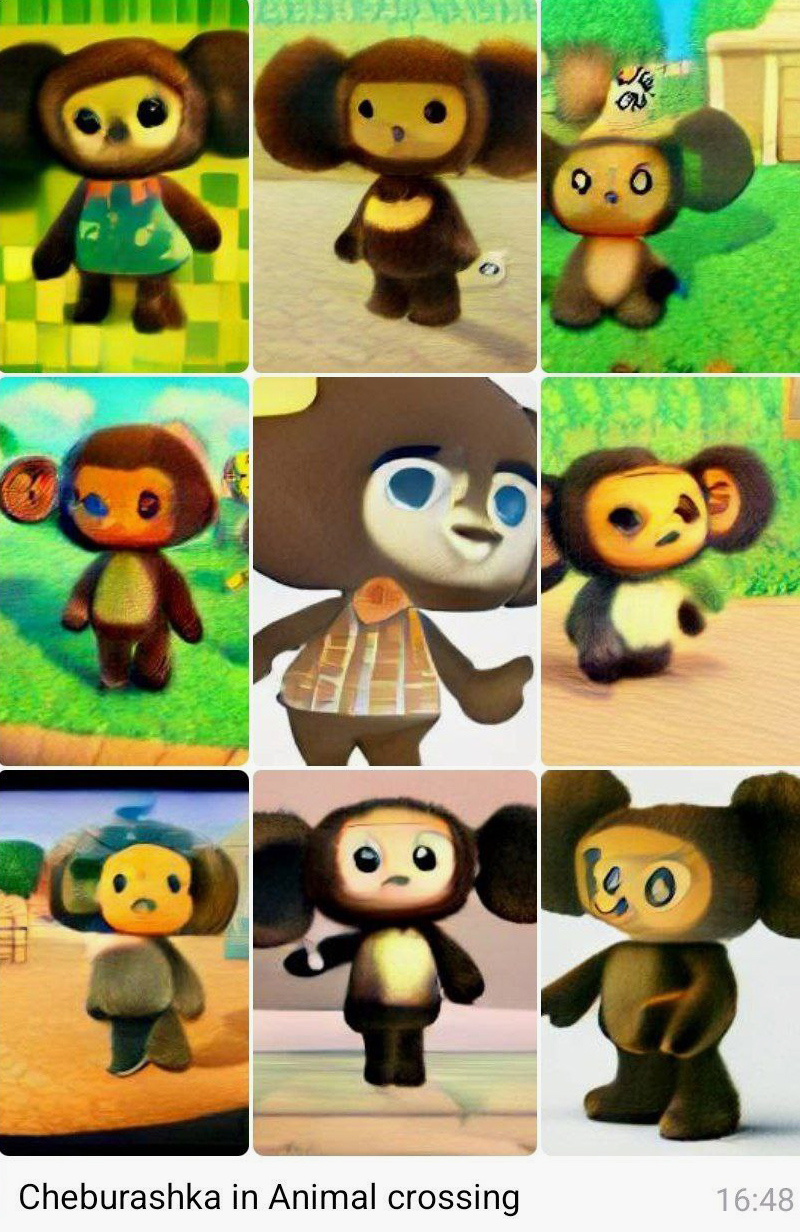

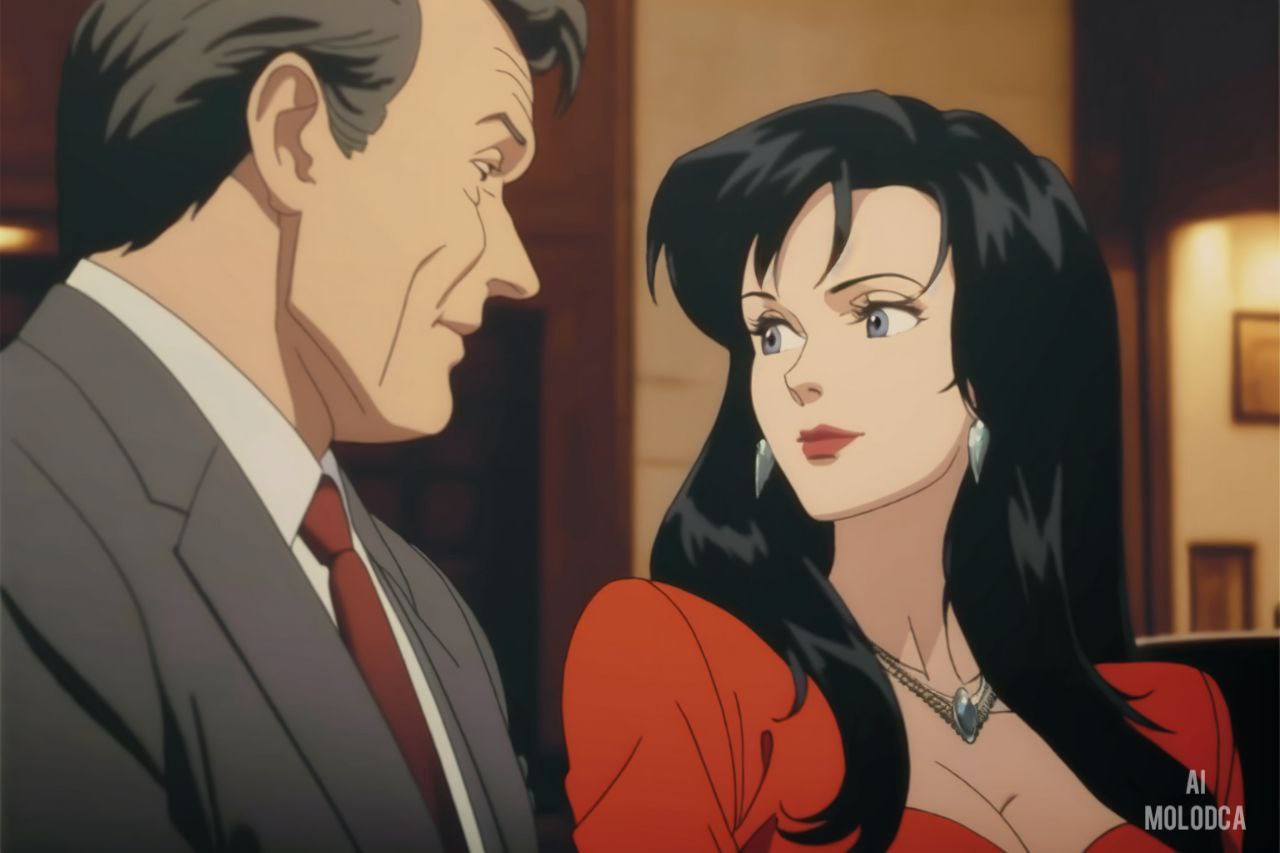

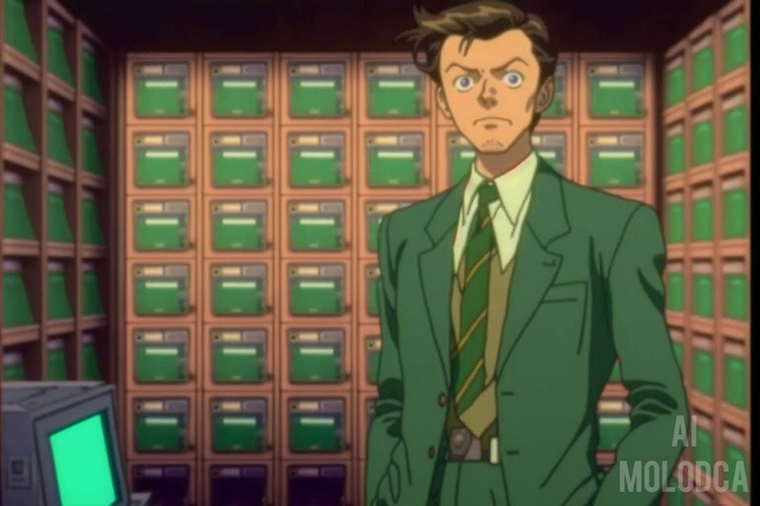

Цифровой художник превращает «Бригаду» в аниме, а «Простоквашино» — в американский ситком.

Он выпустил уже десяток проектов со сгенерированными в нейросетях картинками. На канал Доброкотова Ai Molodca подписаны 17 тысяч человек, но гораздо чаще его работы можно встретить в крупнейших пабликах, соцсетях, СМИ и вообще по всему рунету. Большинство изображений художник генерирует в Midjourney. Нейросеть не требует навыков программирования или глубоких познаний. Но требуется много времени и сил, чтобы подобрать запросы и сформировать собственный узнаваемый стиль.

Мы поговорили с Александром Доброкотовым о том, как он познакомился с нейросетями и придумал авторский метод генерации картинок, которым пользуются другие ИИ-художники. И почему всем нужно подружиться с нейросетями.

Как я познакомился с нейросетями

Я работаю креативным директором в рекламном агентстве DADA, управляю командой и стараюсь делать так, чтобы люди не ненавидели рекламу. При этом всегда занимался личными творческими проектами: иллюстрацией, блогами, видео, арт-пабликами.

Реализация постоянно менялась, потому что идея для меня всегда была важнее формы. Сейчас же наступила новая эпоха креативности: нейросети дали идеальный инструмент для реализаций идей в любом виде.

Работа в рекламе обязывает быть в авангарде культуры и технологий. Поэтому еще в 2015 году, когда Google выпустил DeepDream, я преобразовал несколько картинок в сюрреалистичные фракталы из собак — больше сервис ничего не умел. После этого забыл про нейросети на несколько лет, лишь иногда почитывал информацию о новинках.

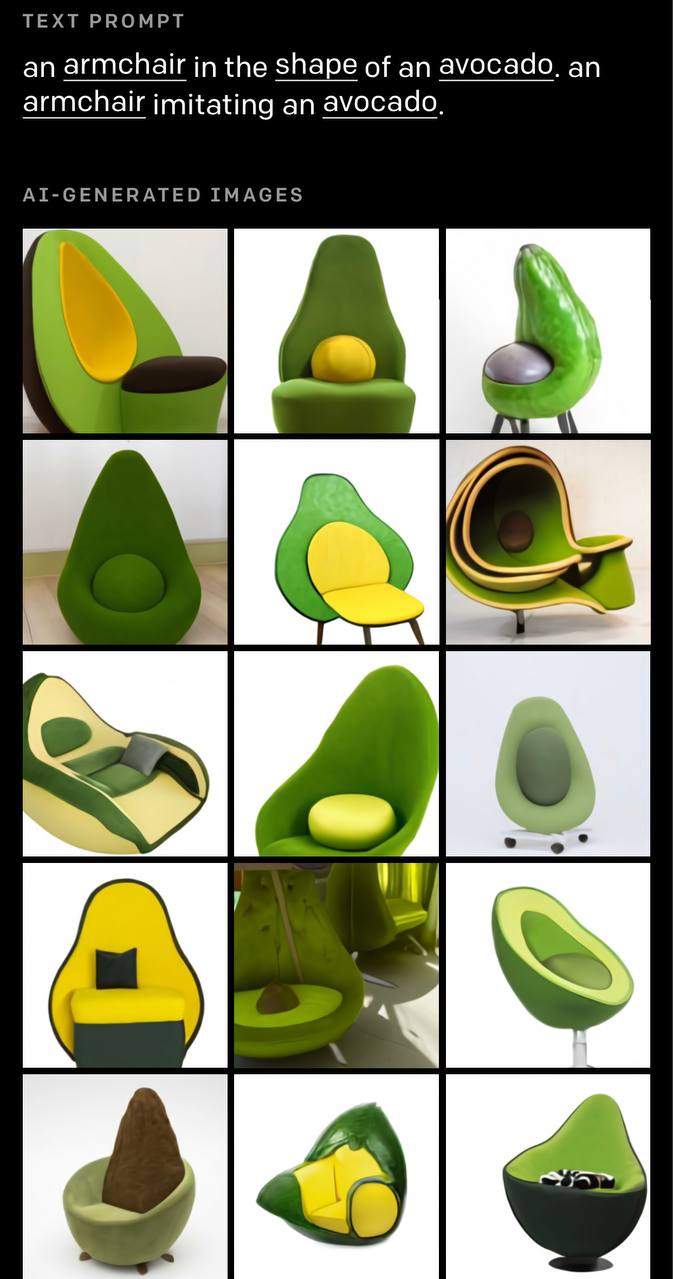

В январе 2022 года в телеграм-канале Denis Sexy IT я увидел работы, сгенерированные с помощью Dall-E. Это первая нейросеть от компании OpenAI, которая умела «рисовать» качественные картинки по текстовому описанию.

Попробовать нейросеть тогда было нельзя, она находилась в закрытой бете. Но даже демонстрация возможностей — превращение текста avocado armchair в авокадное кресло — выглядела настоящей магией.

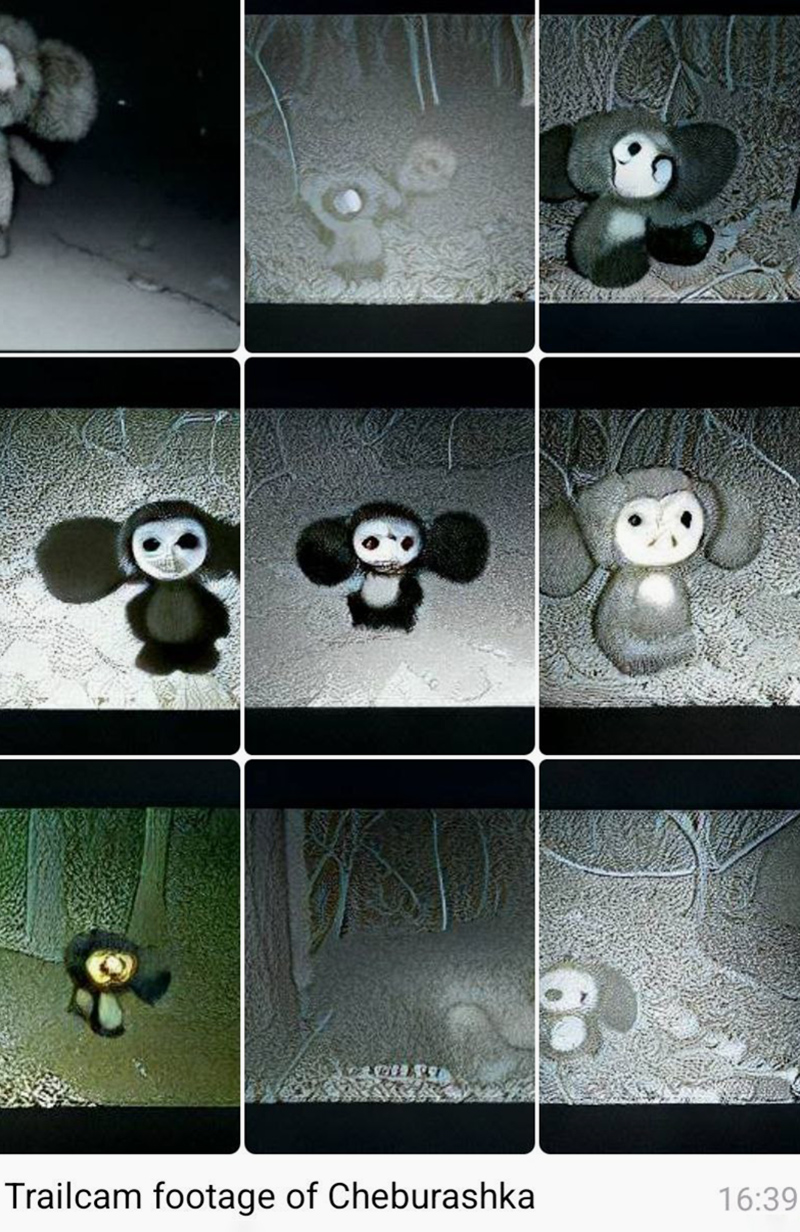

Стало понятно, что картиночные нейросети взорвут интернет, но я не предполагал, что это произойдет так быстро. В апреле появилась и завирусилась модель Dall-E mini, которая генерировала девять не очень качественных, но узнаваемых картинок.

Плохое качество и доступность понравились интернету. Люди помчались генерировать Око Саурона с газетой, пиццу в посудомоечной машине, Карла Маркса на премии MTV. Тогда и сделал канал, чтобы выкладывать свои генеративные эксперименты и учиться промптингу.

Летом 2022 года я получил доступ ко второй версии Midjourney. Модель была на закрытом бета-тестировании, и про нее знали лишь немногие энтузиасты. Качество, мягко говоря, было далеко от того, что спустя больше полугода демонстрирует пятое поколение, но в моменте это было потрясающе.

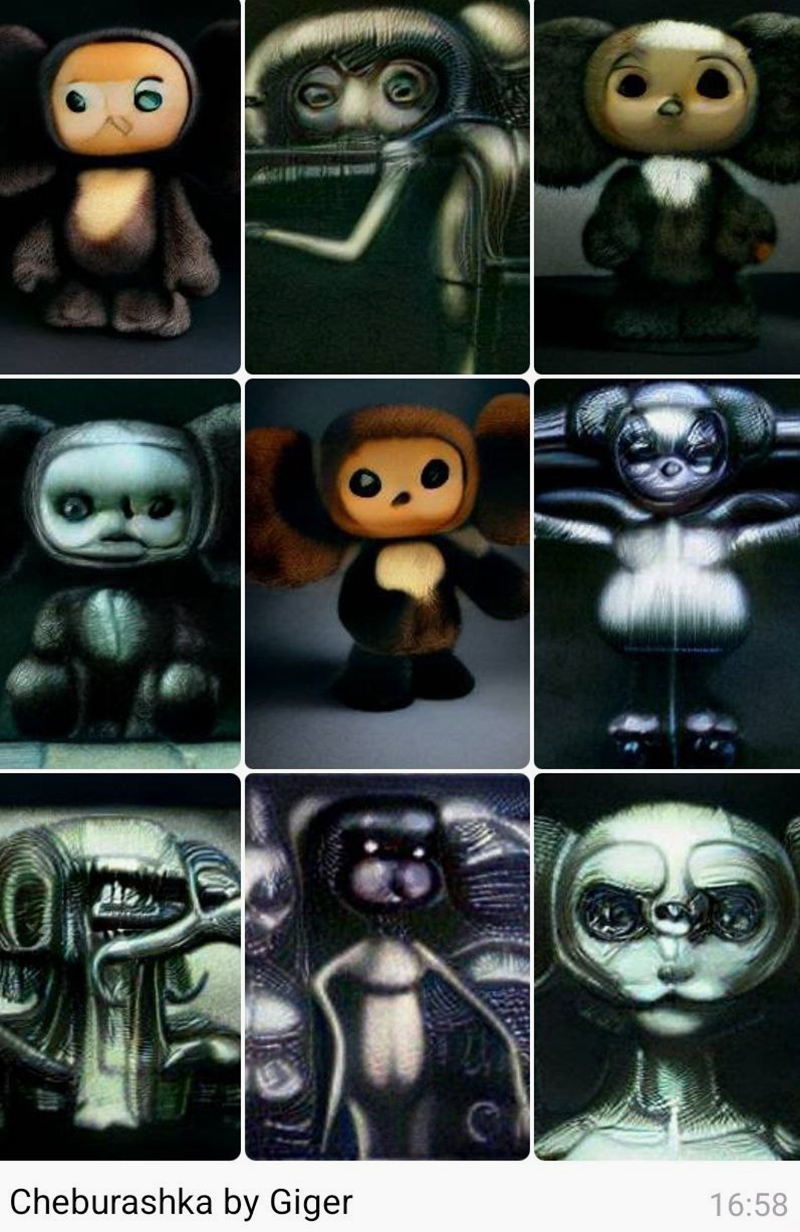

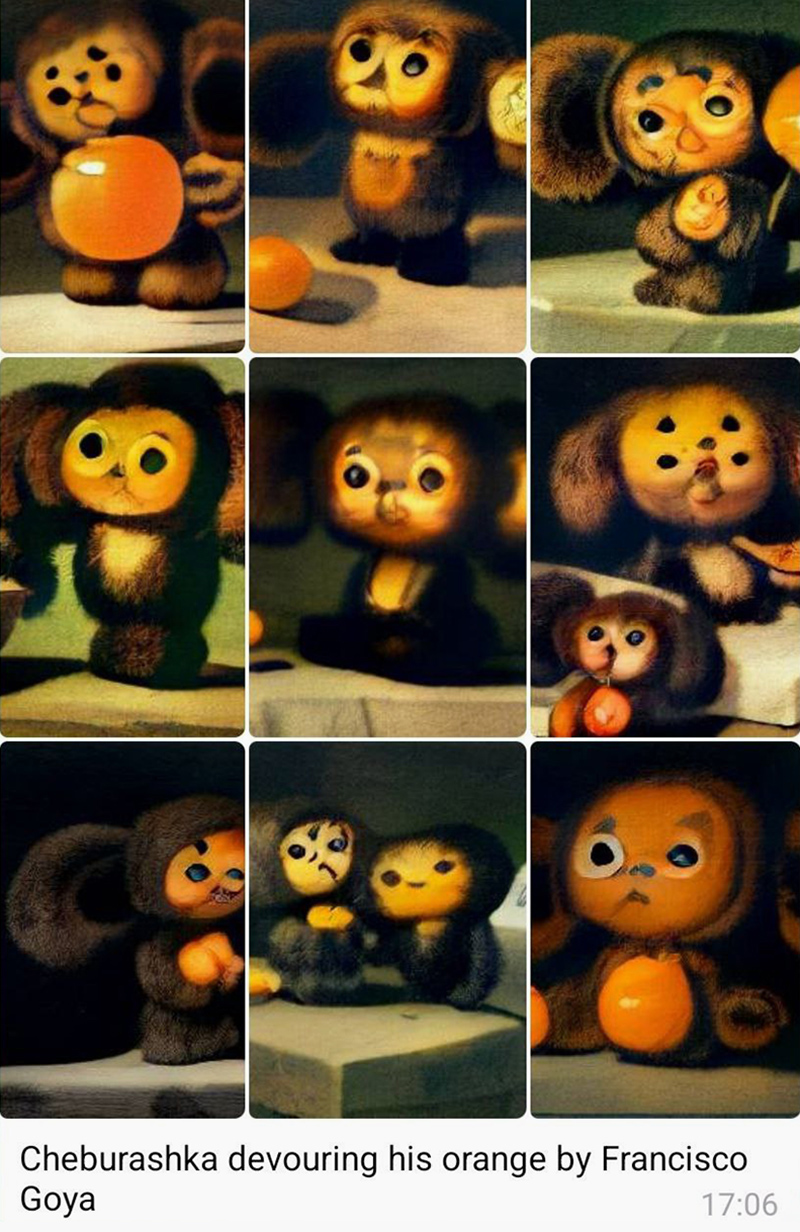

Я тестировал возможности нейросети и сделал свой первый генеративный проект: представил, как бы выглядел сочный бургер в исполнении известных художников вроде Винсента Ван Гога, Ивана Шишкина, Рене Магритта и других. Серия картинок разошлась по пабликам и попала в СМИ.

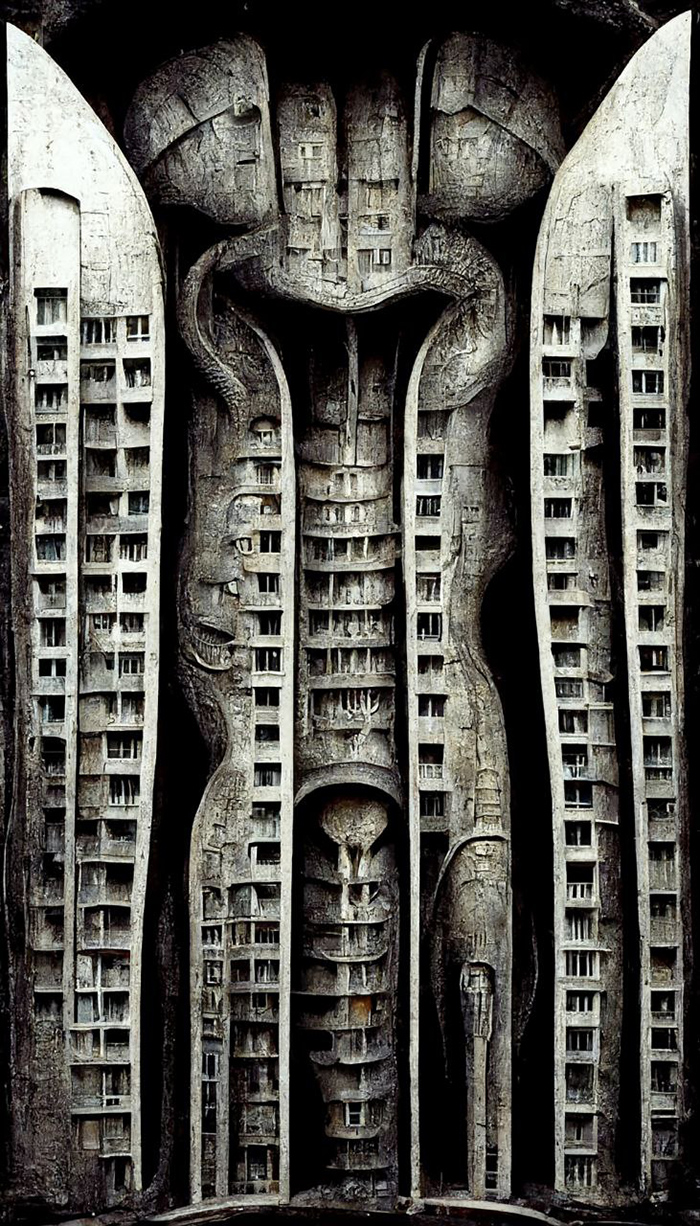

Уже с третьей версией Midjourney хитом стала подборка «Нейропанельки». Тестируя возможности, я представил, как выглядели бы дома в самых разных стилях, не только художественных. Сгенерировал пиксельные, вафельные, шоколадные, киберпанковые, адские панельки. И снова попал в новости: об этом писали РБК и даже крупный англоязычный развлекательный сайт BoredPanda.

Почему из всех нейросетей я выбрал Midjourney

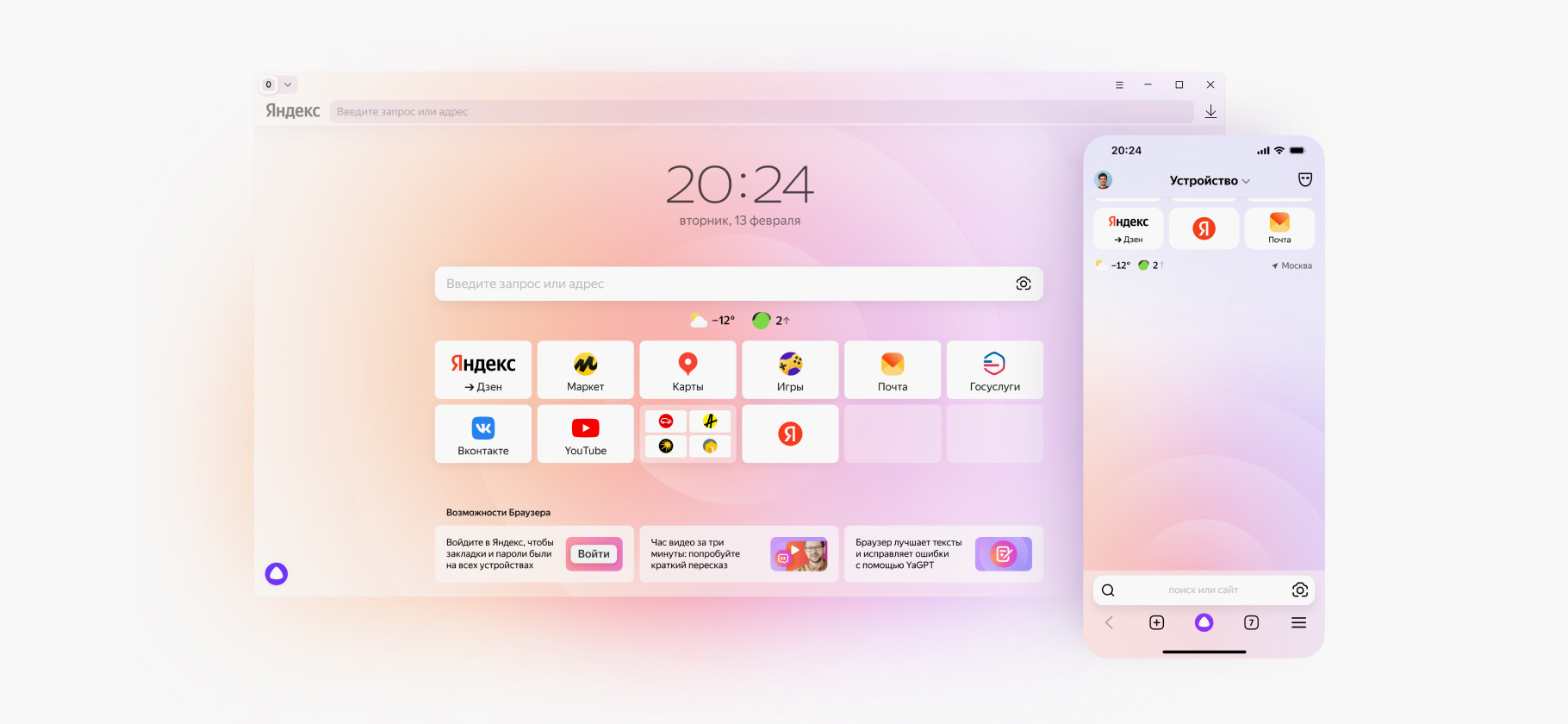

Среди сервисов для генерации картинок есть два очевидных лидера — Midjourney и Stable Diffusion. Первая — самая удобная, вторая — самая разнообразная и настраиваемая, еще и бесплатная.

Midjourney довольно быстро превратилась в феномен из-за минимального порога вхождения и постоянно растущего качества. Конечно, во многом это заслуга авторов контента. Креативщик-трендсеттер делает вирусный прикол и попадает в новости с заголовком «Midjourney показала…». Это видят люди и думают: «Хочу так же!» И так по экспоненте. Сейчас, когда бесплатные генерации прикрыли, порог вхождения стал сложнее, но этот медийный поезд уже не остановить.

Я получил доступ к закрытой бете модели Stable Diffusion 1.4 примерно одновременно с ростом популярности Midjourney. Сидел в чате энтузиастов канала «Нейроэстетика» и восхищался вместе со всеми. Midjourney на тот момент выдавала по большей части высокий уровень абстракции, да еще и ограничивала в тестовых попытках.

Stable Diffusion же уже тогда была бесплатной и с кучей тонких настроек. Сейчас же это мощнейшая открытая модель, способная при определённом шаманстве закрыть все визуальные потребности. Обучить нейросеть на стиле или объекте, стилизовать видео и сделать анимацию, ретушировать изображения, задать позы, встроить возможность генерации в «Фотошоп» или «Фигму» — все это возможно благодаря множеству плагинов, созданных талантливыми энтузиастами.

Единственный минус — порог вхождения. Непонятно, куда бежать и что нажимать. Про Stable Diffusion пишут везде, но при этом нигде не говорят, как ей пользоваться. Весь инструментарий собран только в интерфейсе Automatic1111 и его аналогах. Но новичку, который ожидает кнопку «Сделать красиво», придется попотеть, чтобы туда попасть и изучить все тонкости.

Если сравнивать две нейросети, то Midjourney — это Mac, а Stable Diffusion — Linux.

В Midjourney все просто и понятно. Нужно только зарегистрироваться в Discord и разобраться там с системой каналов. Все происходит в общих чатах, и если что-то непонятно, можно подсмотреть, что генерируют другие участники сообщества. Единственная сложность — оплатить из России.

Промптинг тоже различается. Midjourney и есть та самая кнопка «Сделать красиво». Нейросеть сразу генерирует картинку с «украшательствами», уродливости добиться там сложно, даже если делать это специально. Даже примитивный промпт из нескольких слов сработает хорошо.

А вот Stable Diffusion — чистый лист. С простым запросом и базовой моделью получить достойный результат сложно. Нужно либо пользоваться одной из дополнительных моделей, заточенной, например, на фотореализм, либо дорабатывать промпты.

Большую часть творческих проектов я реализовал в Midjourney, так как она идеально удовлетворяет критериям качества и скорости. Однако Stable Diffusion более гибка, поэтому я использую ее в некоторых работах.

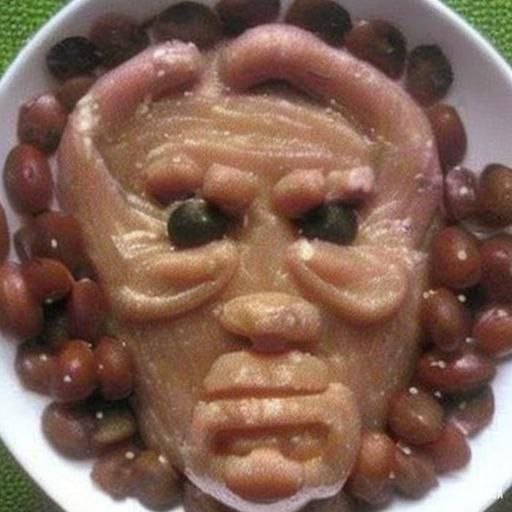

Одна из моих любимых функций нейросети — обучение. Я несколько раз обучал ее на своих фотографиях, карательной кулинарии и ЖЭК-арте. Это открывает бесконечные возможности для экспериментов и «майонезных змеек» в стиле Клода Моне.

Как обучить Stable Diffusion

Обучение Stable Diffusion не слишком сложное, но с нюансами. Все мы обучались, когда использовали приложение Lensa и генерировали себе аватарки. Есть два пути:

- Через интерфейс Automatic1111. Это бесплатно, но сложно. Требуется мощный компьютер или Google Collab. В интернете уже есть множество обучающих материалов.

- Через сервис Astria. Это легко, но платно. За несколько долларов вы можете обучить Stable Diffusion, скачать полученную модель и использовать ее в Automatic1111 или любом другом удобном интерфейсе. Для оплаты необходима международная банковская карта.

Dall-E 2 могла бы стать потенциальным конкурентом для двух главных нейросетей. Она появилась до того, как Midjourney и Stable Diffusion стали широко обсуждаться, и по качеству генерации опережала свое время. Но, к сожалению, модель проиграла в медийной гонке. Она долго оставалась в режиме закрытого тестирования и упустила момент, когда такие сервисы стали интересны большой аудитории. Поэтому о Dall-E 2 говорят не так много, как о Midjourney или Stable Diffusion, хотя она также весьма неплоха, особенно функция Outpainting.

Однако модель была интегрирована во все сервисы Microsoft. Например, в Bing картинки генерируются с помощью Dall-E 2.

Как я нашел свой стиль

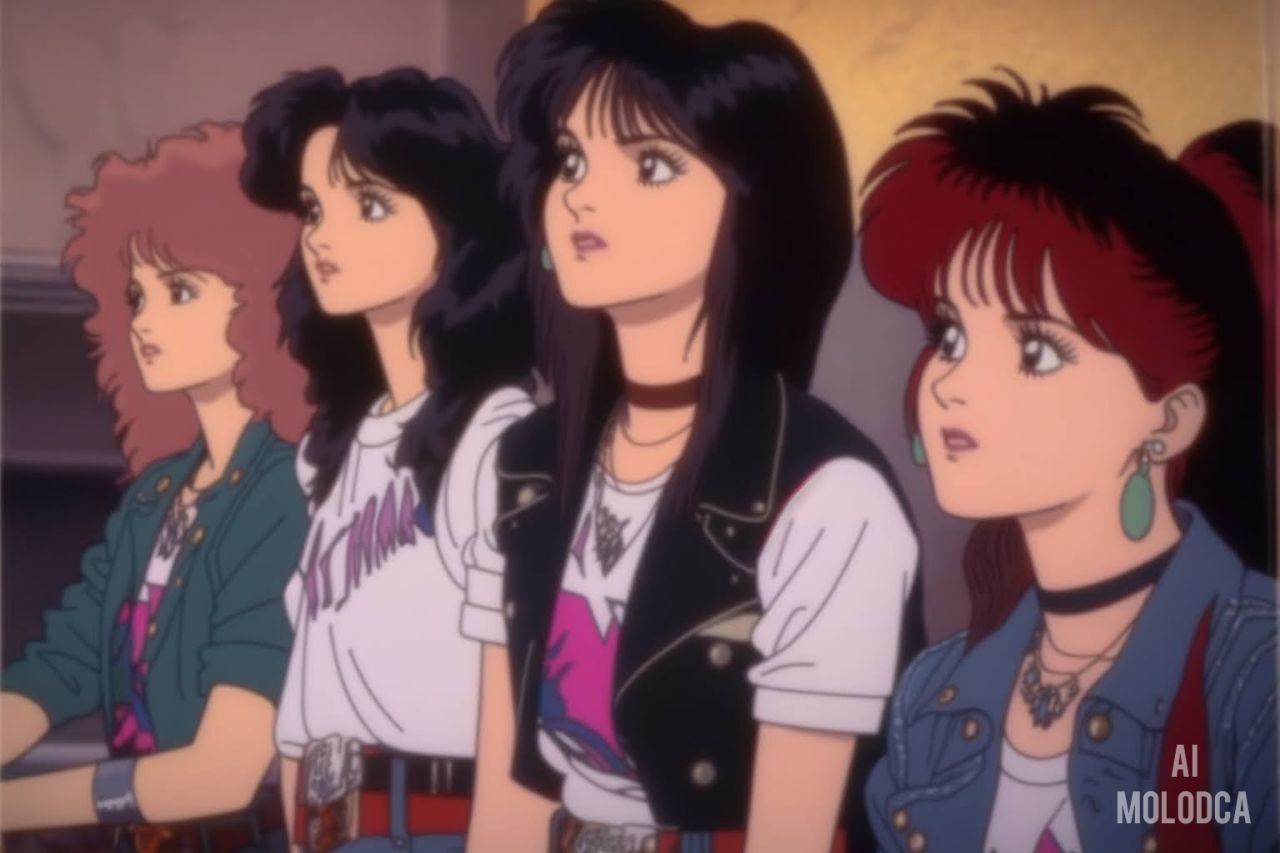

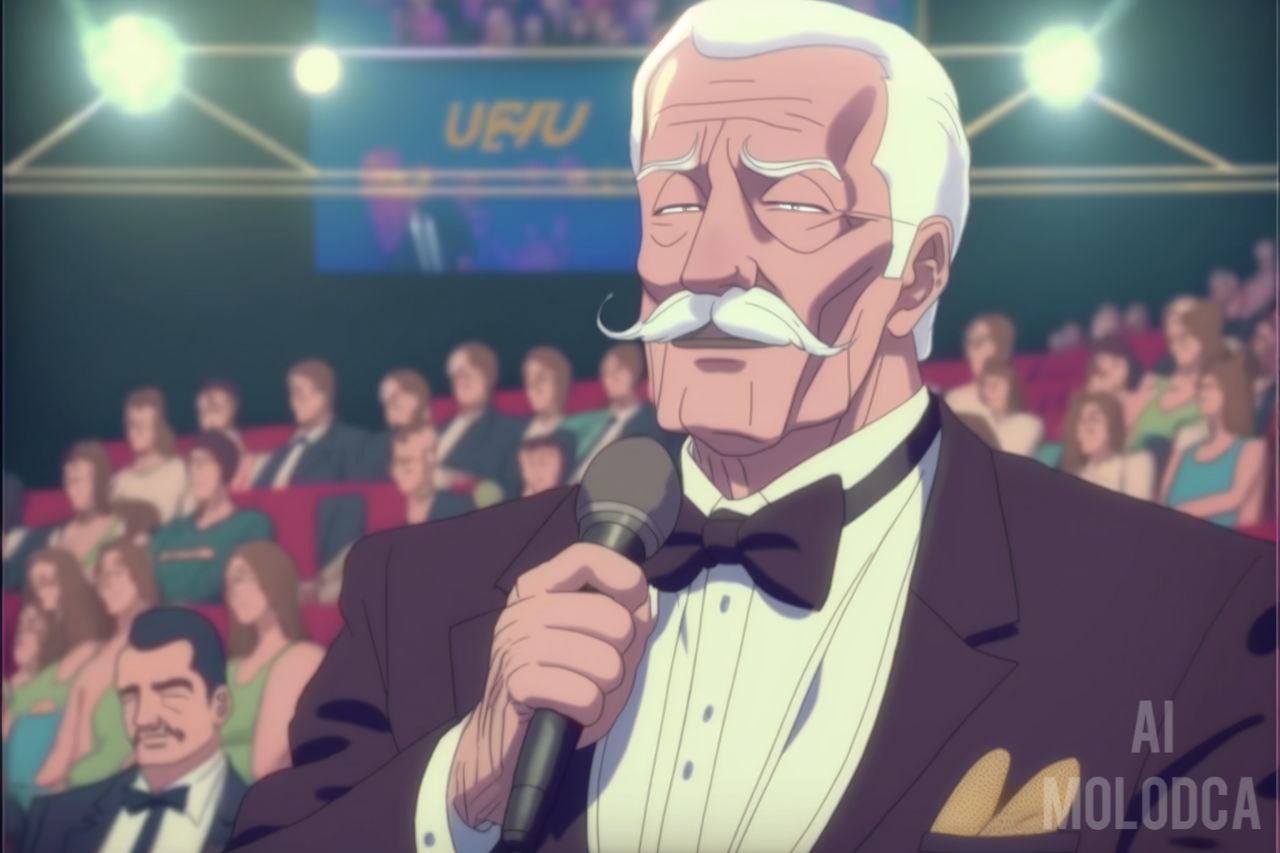

Я вырос в 90-е, когда новое западное танцевало со старым советским. Поэтому в моем культурном коде панельки, ковры и гопники сосуществуют с фильмами французской новой волны, аниме и Арнольдом Шварценеггером. Это смешение и отражается в творчестве.

Midjourney с четвертой версии как раз позволяет смешивать образы и стили за счет соединения нескольких изображений. На моем канале даже есть рубрика «мешалка», где я смешиваю котов с хлебом, Гигачада со Шреком и сыр с колбасой. Несмотря на то что у меня получаются шуточные результаты, это потрясающий инструмент. Он на фундаментальном уровне отражает суть креативности: соединять то, что никто раньше не соединял.

Зачастую я использую картинки-референсы, потому что героев советской и постсоветской поп-культуры в датасете Midjourney, конечно же, нет. Западные мемы и знаменитости генерируются легко, но нарисовать по текстовому запросу Якубовича или голубя из покрышек не получится.

Ностальгия хорошо работает. Сейчас, когда мир летит в ад, людям особенно хочется вернуться к понятному и привычному. Узнаваемые образы работали всегда, но сейчас, мне кажется, есть дополнительный спрос на это.

Идеи можно придумывать по-разному, есть множество креативных методик, которые я использую в работе. Для генерации картинок подходит простая техника 3B: bathroom, bath и bed. Это три места, где обычно скучаешь и где нет внешних стимулов, которые бы занимали голову. Скучающий мозг в пассивном режиме начинает соединять разные концепции, образы и идеи. Так рождаются новые. Поэтому смело скучайте, это продуктивно. Но только без телефона.

На один проект уходит примерно четыре дня, но все зависит от сложности идеи. Самым трудным было «Простоквашино» в стиле ситкома. До этого я превращал сериалы с людьми в аниме, а здесь нужно было попробовать сделать наоборот: из мультфильма получить реалистичное шоу в стиле 80-х.

Midjourney, в отличие от Stable Diffusion, сложно контролировать, поэтому верный способ направить нейросеть — использовать скетчи. В большом мире продакшена для кино и игр создаются концепт-арты. В Midjourney можно точно так же отдельно генерировать персонажей, одежду, сетапы, а потом использовать это как референсы.

Как генерировать по методу глубокого референса

Метод глубокого референса позволяет генерировать персонажей, которых «не знает» Midjourney. Вот как это сделать:

- Возьмите картинку с героем и вставьте ссылку в Midjourney. Это будет основа запроса.

- После ссылки напишите запрос, который описывает вашу картинку. Например, если на ней герой сидит на берегу реки, так и пишите: «A man sitting near river». Опишите его внешность, одежду, особенности и другие черты, которые важны для образа.

- Выберите понравившуюся картинку и увеличьте разрешение.

- Добавьте в новый запрос оригинальную и сгенерированную картинки, а также текст промпта. Запустите генерацию еще раз.

- Исправляйте детали в текстовом запросе, пока не добьетесь нужного результата.

Подробнее об использовании метода с примерами смотрите в моем ролике на «Ютубе».

Даже при использовании глубокого референса возникают проблемы. К примеру, на аниме-Парфенова ушло 50 итераций. Мне нужны были зеленые шкафы на фоне из шоу «Намедни» на НТВ, а Midjourney красила в зеленый все подряд: одежду, лицо, волосы. Это решается только методом проб и ошибок.

Для одного проекта я генерирую 200—400 изображений, а на одну картинку уходит 20—50 итераций. Я долго выбираю: мог бы остановиться на приемлемом варианте, но всегда подкручиваю и стараюсь добиваться идеала.

В «Фотошопе» стараюсь ничего не дорисовывать, но иногда приходится. Например, когда создавал «Тайну третьей планеты» в стиле «Звездных войн», не мог даже близко сгенерировать каноничного Громозеку, потому что нейросеть не понимает концепции существа, похожего одновременно на слона и осьминога. Пришлось дорисовывать недостающие руки.

У подписчиков в тематическом челлендже тоже не получилось: Громозеки просто невозможно добиться от Midjourney.

Что будет дальше

Мы на сверхскоростях влетаем в новую эпоху ИИ, и нас ждет много как прекрасного, так и не очень. Например, постправда. Раньше текстовые fake news были проблемой. Теперь к ним добавляются генеративные суперреалистичные фото: тот же папа римский в пуховике Balenciaga. Прибавьте сюда доступные технологии клонирования голоса, дипфейки и людей с плохими намерениями.

Пока пользователи генерируют приколы, но, мне кажется, рано или поздно произойдет очень неприятный инцидент с использованием генеративного контента, который может запустить движение за маркировку всего ИИ-контента в интернете.

Уже сейчас иногда трудно понять, что реально, а что нет. Недавно заказал рекламу своего канала на щите в Урюпинске, а некоторые подписчики подумали, что это генерация. К щиту даже пришли люди, сфоткались рядом, а им пишут: «Да это тоже генерация по запросу: „Girl standing in front of billboard, purple hair“».

В этой сфере правовое поле развивается медленно, как черепаха, гоняющаяся за зайцем, но намечается определенный тренд. Например, Stability AI столкнулась с судебными исками за использование контента для обучения без согласия. А Adobe движется в сторону «экологичности», обучая Firefly с согласия авторов и выплачивая роялти.

Мне было бы приятно, если бы я был известным иллюстратором и мои работы попали в датасет, а в промптах писали by Dobrokotov вместо Greg Rutkowski. Но здорово и правильно, когда есть выбор: использовать твои работы для обучения или нет. Впрочем, это все на корпоративном уровне. Если мы говорим про Stable Diffusion и любые открытые модели, то их можно обучить на чем угодно, даже на надписях в подъездах.

Картиночные нейросети все еще не идеальны, но почти достигли потолка. Реалистичность Midjourney поражает, а Stable Diffusion позволяет обрести полный контроль над результатом. Однако массовой аудитории все еще сложно с ними обращаться, поэтому востребованы более дружелюбные интерфейсы, а главное — интеграции в существующие и привычные экосистемы, как это делают Adobe с Firefly и Google с текстовыми моделями.

2023 год будет посвящен быстрому развитию генеративного видео и 3D-моделей, как это было с картинками в прошлом году.

Многие переживают, что нейросети заменят людей. Но это вряд ли случится.

Тут стоит ожидать другой тенденции: если не пользуешься ИИ, проиграешь конкуренту, который владеет нейросетями.

Если художник рисует маслом в подвале для души, он может ничего не изучать и быть счастливым. Но если вы работаете в коммерции иллюстратором, копирайтером или креативщиком, умение обращаться с нейросетями станет гигантским конкурентным преимуществом.

В работе мы постоянно используем нейросети: создаем сториборды, раскадровки, презентации, дизайн, тексты. Еще в прошлом году, когда все только начиналось, мы вели соцсети бренда Epica с помощью нейросетей. Теперь открыли специальный отдел и разрабатываем ИИ-проекты и продукты. Владение ИИ — это новая норма. Капитализм расставляет все точки над i: эффективные специалисты получат преимущество. Не стоит бояться, нужно учиться.

Мы вступаем новую эпоху, в которой креативность, идеи и концепции станут определяющими. Ценность внешней формы теряет свою важность, так как с помощью ИИ каждый может ее создать. Важность уникального авторского видения и эмоционального интеллекта возрастает.

Представьте себе фильм с потрясающей графикой, но без захватывающего сюжета и интересных персонажей. Насколько быстро он надоест? Поэтому развивайте креативность и концептуальное мышление. В будущем эти навыки будут наиболее ценными, наряду со способностью быстро учиться, не зацикливаясь на старых знаниях.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult