Я сгенерировал в нейросети кадры усредненной России, которые можно спутать с пленочными снимками известных фотографов

Этот текст написан в Сообществе, в нем сохранены авторский стиль и орфография

Выбор нейросети и составление запроса

Я использовал нейросеть Stable Diffusion, потому что у нее открытый код и больше возможностей. Дообучил официальную модель 2.1 — это заняло у меня полтора часа методом Dreambooth. В основе дата-сета — мои собственные кадры, но еще я добавил снимки галерейных фотографов. Например, Елены Чернышовой, Георгия Пинхасова и Александра Гронского.

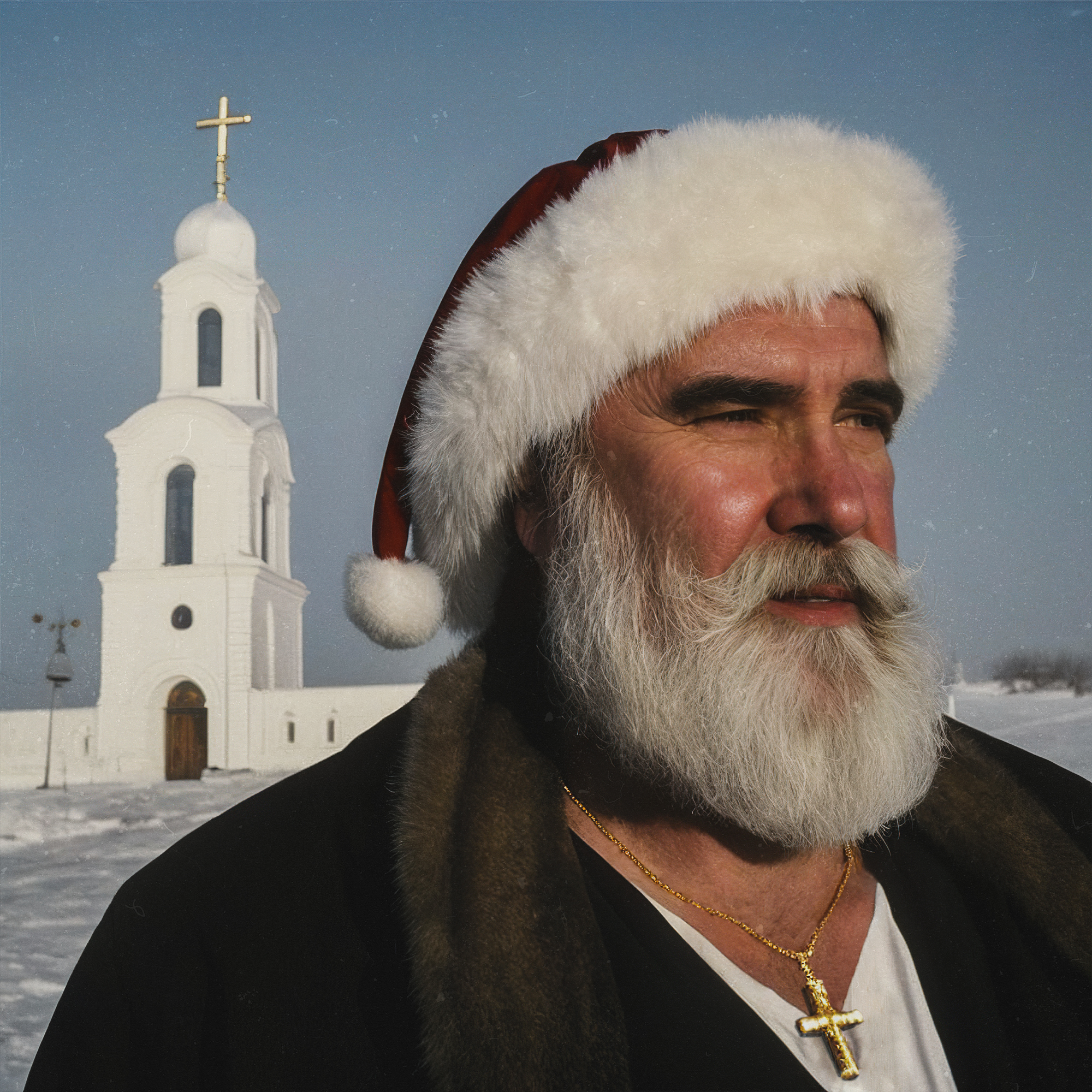

После этого я генерировал простыми запросами: Santa Claus behind tall building, snowy weather, film photo, contrast shadows. Сделал больше тысячи вариантов, потому что преследовал конкретные образы, композицию и цвета. Это давало то же ощущение, что и при съемке в городе: ждешь, смотришь на детали, ищешь тот самый момент — только все это перед ноутбуком.

В Stable Diffusion есть Inpainting: выделяешь зону и генерируешь заново только ее. Этим я тоже пользовался, чтобы подправить детали или поменять цвета. Так я выровнял композицию в кадре с елочкой в окне и создал драматический взгляд у Деда Мороза с крестиком.

Последний шаг — постобработка: увеличил картинки нейросетью Topaz Gigapixel, подкорректировал цвета, замазал артефакты и поднял точку черного для эффекта пленки. Еще я наложил текстуру с шумом. Все вместе сделало генерации менее искусственными.

Впечатления

Это была первая модель, которую я обучал всерьез. До этого я тренировал нейросеть только на фотографиях Кокоса — кота моего друга. Тогда я потратил 3-4 попытки и не сразу понял, какие настройки подходят лучше всего и как отбирать картинки.

Своей моделью я доволен. В моем дата-сете не было новогодних елок, фейрверков или огромных пугающих сугробов, но она смогла вписать даже новые элементы в общую эстетику. Это такой бесконечный генератор России.

Хуже всего она генерировала людей в сложных позах, но это недостаток всех диффузионных нейросетей. Дети на коньках вышли патологическими — я подправил им анатомию. Еще она упускала следы на снегу от людей и уток, поэтому их пришлось дорисовать самому.

Трудности с использованием нейросети

Я с релиза использую Stable Diffusion, поэтому со всеми трудностями разбирался еще летом. Мне помог самый эффективный метод обучения — метод проб и ошибок. Тренировать собственную модель оказалось не так трудно, но вместе с подготовкой дата-сета это занимает больше 4 часов.

Stable Diffusion — в отличие от Midjorney — хуже в простых задачах. Эта нейросеть не сгенерирует красивую иллюстрацию для блога с первого запроса и в среднем хуже понимает запрос. Ее фича — открытый код, комьюнити и кастомизация.