Как распознать текст, написанный нейросетью ChatGPT?

Я учитель литературы. Недавно узнал про сайт ChatGPT: ученики с его помощью пишут сочинения и выдают за свои работы. Можно ли как-то отличить, написал текст человек или нейросеть?

В теории отличить текст, написанный нейросетью, возможно. Исследователи уже несколько лет занимаются тем, что выявляют паттерны ИИ-текста — находят повторяющиеся слова и закономерности в строении предложений и их средней длине.

Но проблема в том, что языковые модели развиваются быстрее, чем их раскусывают. Еще четыре года назад нейросети не могли нормально связать и трех предложений подряд, а теперь выдают логичные тексты. Поэтому способы определить ИИ-текст быстро устаревают.

Что вы узнаете

Как человек может отличить ИИ-текст

Лучше всего распознать текст, который написала нейросеть, может человек. Все дело в насмотренности: чем больше читаешь текстов, сгенерированных ИИ, тем проще определить такой на глаз.

Если вы хотите научиться их распознавать, главный совет — практикуйтесь. Пользуйтесь генераторами текстов, экспериментируйте с разными моделями, параметрами, стилями. Чем больше вы будете работать с ИИ, тем скорее научитесь видеть характерные особенности и «артефакты» сгенерированных текстов.

Если у вас нет времени на долгую практику, вот несколько советов, которые помогут распознать нейросетевой текст.

Нейросеть пишет слишком конкретно. Например, исследователи из Google Brain еще в 2019 году пришли к выводу, что ИИ слишком часто использует артикль the, потому что работает на предсказание следующего слова в предложении. Но понятно, что этот признак присущ только англоязычным текстам.

ChatGPT уже используют как замену поисковым системам, поскольку она дает вполне конкретные ответы. Но с рассуждениями дела у нее обстоят хуже: на вопросы вроде «Что такое любовь?» ИИ выдаст сухую формулировку, а не попытку проанализировать сложное чувство.

Также нейросеть может очень уверенно написать абсолютную неправду — это называется галлюцинацией. Такое происходит, когда у ИИ недостаточно данных о реальном мире. Поэтому он начинает компенсировать пробел в знаниях выдумками.

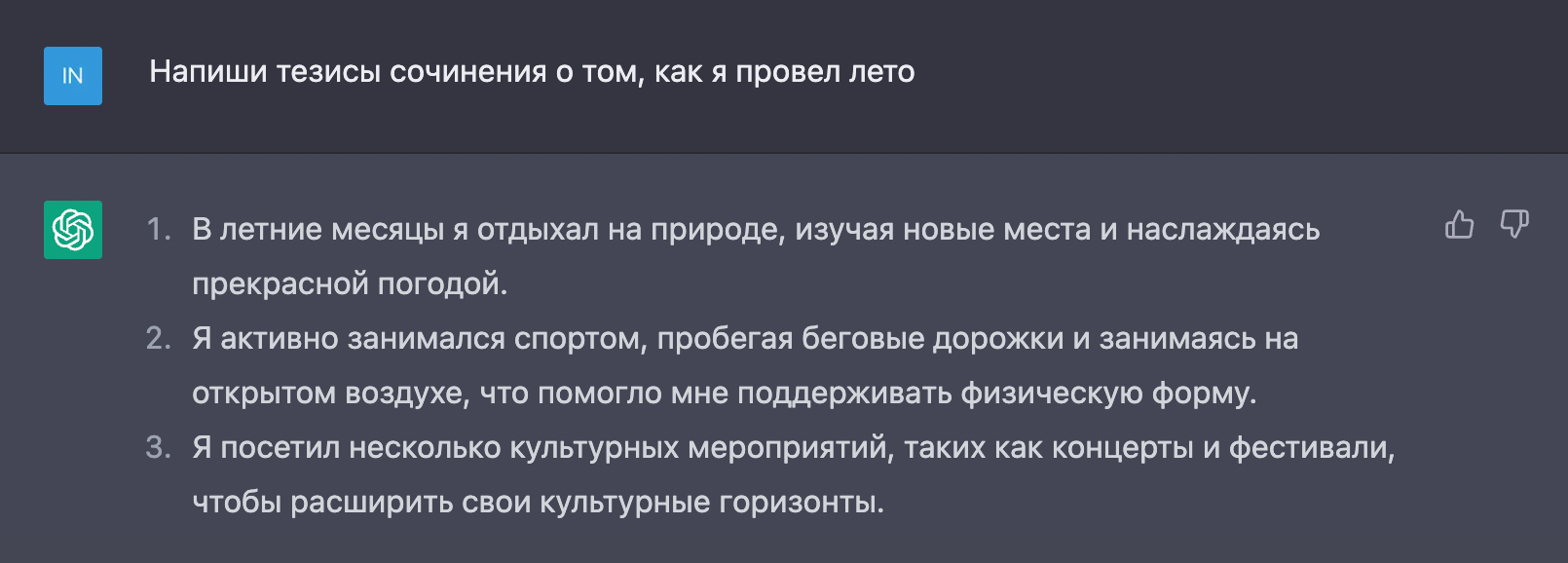

Нейросеть опускает контекст и персонализацию текста. ChatGPT не сможет передать опыт конкретного человека — только попытаться имитировать опыт миллионов людей, на чьих текстах обучена модель. Но таким материалам обычно не хватает глубины и авторского ощущения: одно дело — написать шаблонное сочинение по литературному произведению, и другое — рассказать, как ты провел лето.

С экспертностью то же самое. Многие тексты ChatGPT достаточно полезны, но в них нет углубления в тему. Это может сделать только человек с богатым личным опытом.

При этом новая версия языковой модели гораздо лучше работает с контекстом, чем ее предшественники. Поэтому теоретически уже после генерации можно попросить ChatGPT подредактировать текст и сделать его «более человеческим». Но от этого он не станет выглядеть полностью живым. Добиться хорошего результата можно, только если редактурой займется человек.

Нейросеть пишет большинство текстов по одинаковой структуре. Обычно они состоят из вступления, основной части и вывода. Во вступлении нейросеть представляет тему, дает общий контекст. Основная часть текста состоит из нескольких абзацев, каждый раскрывает отдельный аспект темы. Но переходы могут быть нелогичными, а связь между абзацами — не очень четкой. В заключении нейросеть старается подвести итог, сделать выводы из сказанного. Но они общие и предсказуемые.

Стиль текста безэмоциональный. Нейросетям сложно передавать эмоции, сарказм, иронию, юмор. Поэтому их тексты часто выглядят сухими и формальными по стилю. Еще нейросети обучены быть нейтральными и объективными, поэтому они стараются избегать резких, категоричных суждений. В их текстах мало критики, негативных оценок, субъективных мнений.

В сгенерированном тексте много «воды». Это связано с особенностями обучения нейросетей: они стараются генерировать связные правдоподобные тексты, имитируя стиль и приемы человеческих. При этом нейросети не всегда четко выделяют главную мысль, повторяют одно и то же разными словами, используют ничего не добавляющие к сути фразы. Часто из нескольких абзацев сгенерированного текста вытекает только одна мысль.

Нейросеть не допускает грамматических ошибок. В Google Brain отмечают: люди чаще указывают, что логичный текст без ошибок написал человек. Хотя идеальная грамотность как раз больше присуща ИИ: люди не там ставят запятые, опечатываются, используют сленг и сокращения. Такого уровня имитации нейросети пока не достигли.

Нейросеть может противоречить сама себе. Поскольку она генерирует текст на основе паттернов и статистики, а не глубокого понимания темы, в разных частях текста могут встречаться противоречащие друг другу утверждения. Особенно это заметно в длинных текстах, где нейросеть может «забыть», о чем писала ранее.

Какие сервисы помогут отличить ИИ-текст

С сервисами есть две проблемы. Первая — они нестабильны. Могут определять текст, написанный нейросетью, как оригинальный, а текст, созданный человеком, — как сгенерированный. Например, один из них определил, что Конституция США на 92% создана ИИ.

Вторая проблема в том, что многие сервисы или вообще не работают с русским языком, или плохо с ним справляются и из-за этого не могут правильно определить авторство текста.

Расскажу про несколько вариантов, которые советуют чаще всего. Чтобы их протестировать, я использовал три материала. Первый я сгенерировал на английском языке, второй — на русском, а третий написал мой коллега без помощи ИИ.

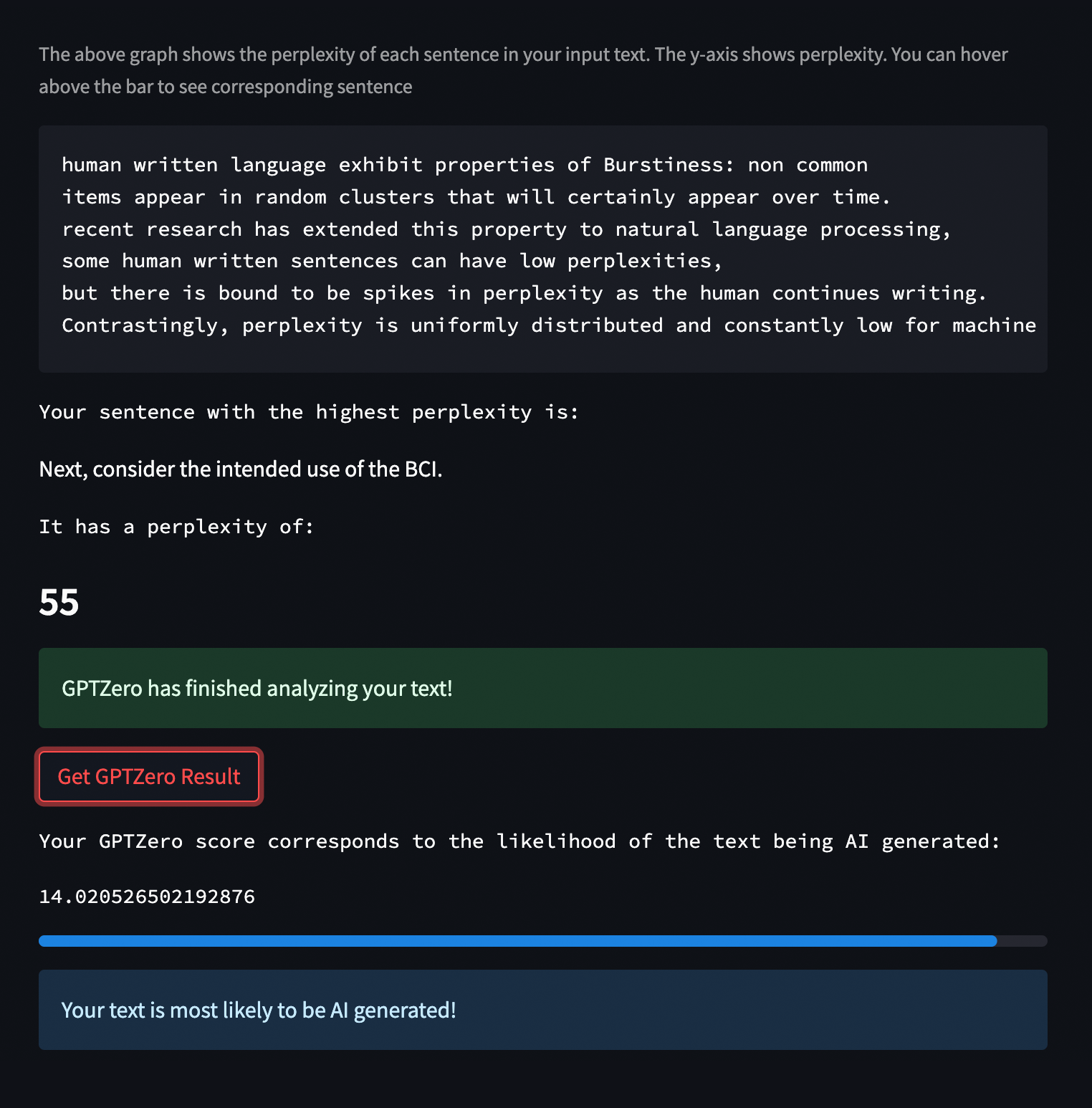

GPTZero — сервис 22-летнего американского студента Эдварда Тиана. Он сделал его в январе 2023 года, и инструмент сразу же обрел популярность. В разработке уже продвинутая платная версия GPTZero, но я пользовался бесплатной классической.

Сервис анализирует текст по двум параметрам:

- Perplexity считает предсказуемость текста: люди пишут сложнее и используют менее очевидные сочетания слов.

- Perplexity оценивает структуру и длину предложений.

Понять итоговые оценки сложно, так что после анализа можно пролистать страницу вниз и нажать «Получить результаты».

В моем случае GPTZero верно оценил авторство текста на английском языке, но с русским не справился — выдал ошибку. В соцсетях пишут, что GPTZero легко обмануть, но с базовыми материалами он справится.

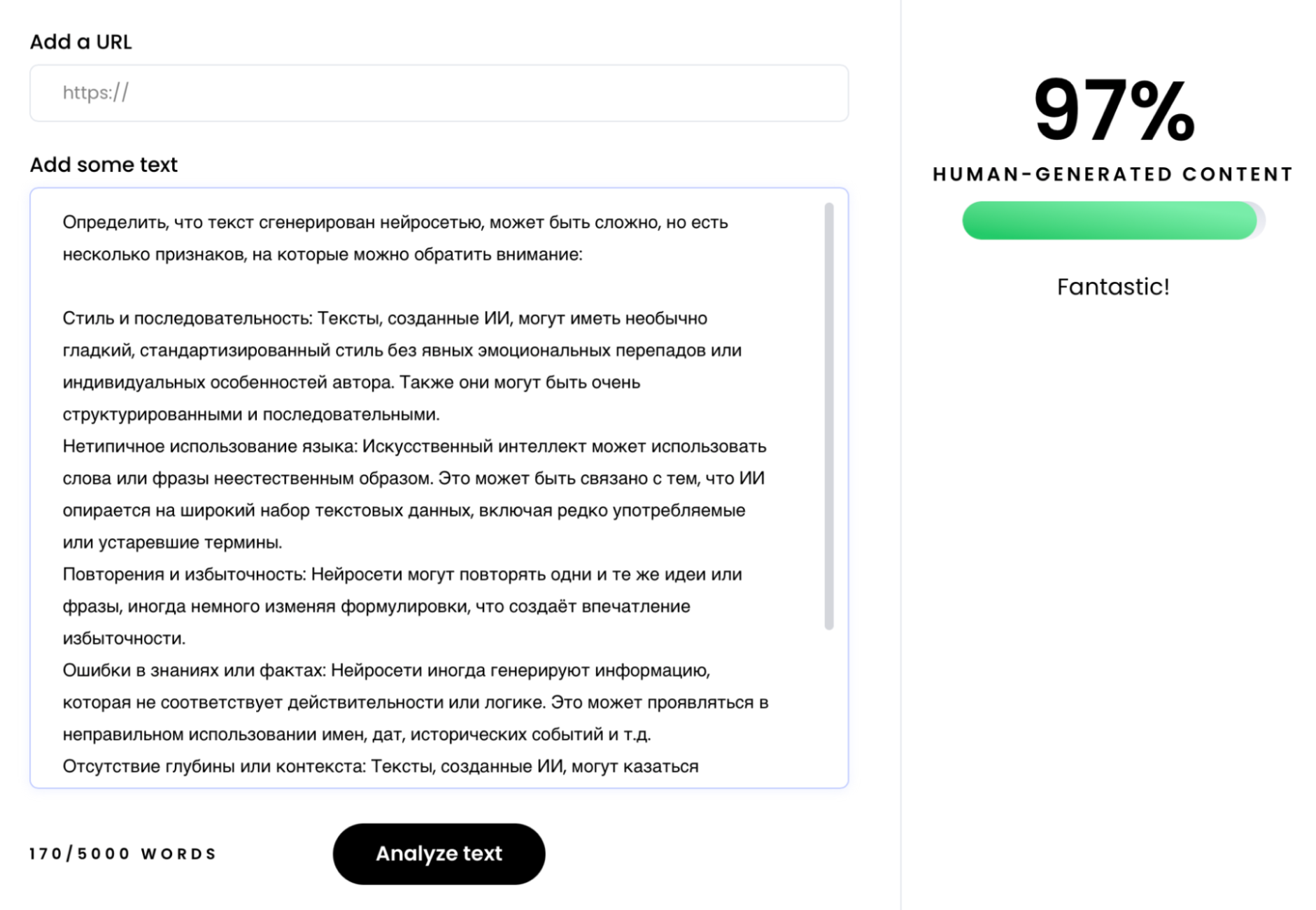

Writer AI Content Detector — коммерческий проект, который сделали разработчики ИИ для создания текстов. Он позволяет вставить ссылку на текст или скопировать до 1500 символов в поле на сайте. Затем выдает процент, определяющий, с какой вероятностью текст сгенерирован или написан человеком.

В практическом тесте сервис полностью провалился. Он определил, что сгенерированный текст на русском с вероятностью 97% написан человеком, а на английском — с вероятностью 91%. Текст от моего коллеги он тоже отнес к человеческим. Сложилось впечатление, что цифры выдаются абсолютно случайно. Тем более что сервис никак не комментирует свое решение.

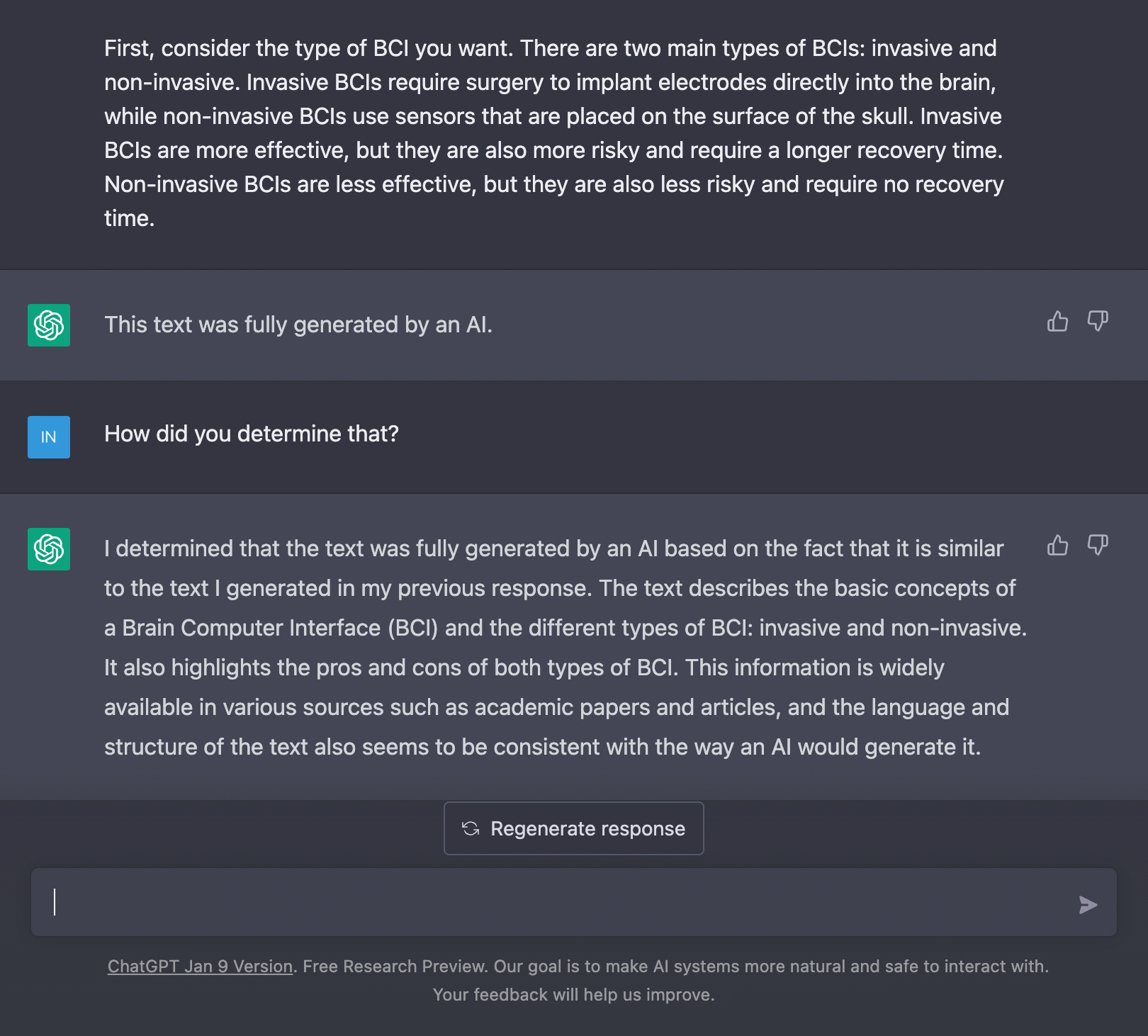

ChatGPT — это вариант победить врага его же оружием. Скиньте самой продвинутой нейросети кусок текста и спросите, написал ли его ИИ. Учитывая, что ChatGPT запоминает предыдущие сообщения и остается в контексте диалога, задайте дополнительные вопросы, как чат-бот пришел к своему выводу.

В моем случае нейросеть отлично справилась с материалом, который сама же и сгенерировала. Заодно рассказала, что в тексте приведена слишком базовая и распространенная в сети информация. А вот сгенерированный текст на русском языке ChatGPT принял за человеческий.

Результаты моего тестирования сервисов

| Writer AI Content Detector | GPTZero Classic | ChatGPT | |

|---|---|---|---|

| Определил ли ИИ-текст на английском языке | Принял за человека | Да | Да |

| Определил ли ИИ-текст на русском языке | Принял за человека | Выдал ошибку | Принял за человека |

| Определил ли текст человека на русском языке | Да | Выдал ошибку | Да |

Мой опыт показал, что процент ошибок слишком велик, чтобы полагаться на сервисы.

К тому же в марте 2024 года сингапурские и вьетнамские ученые выяснили, что точность ИИ-детекторов в среднем всего 39,5%. А если добавить в сгенерированный текст опечатки, орфографические ошибки, сделать предложения разной длины, показатель уменьшится до 22%.

Раньше у OpenAI был собственный определитель нейросетевых текстов. Но в 2024 году он перестал работать, а компания не прокомментировав решение. Возможно, это произошло на фоне обсуждений того, что ИИ-детекторы непредсказуемы.

Чего ждать дальше

Крупные платформы внедрят собственные системы проверки ИИ-текстов. Подобные решения уже анонсировали платформа для авторов Medium и ресурс для программистов Stack Overflow. Можно ожидать, что в будущем такие сервисы будут у всех крупных соцсетей и платформ.

У сгенерированных текстов появятся вотермарки. Эту технологию уже разрабатывают в OpenAI. По словам сотрудника компании Скотта Ааронсона, у сгенерированных через GPT текстов будет скрытый криптографический сигнал, который поможет быстро определить авторство.

Вот как это должно работать:

- Создают список специальных слов. При генерации текста языковая модель выбирает эти слова чаще, чем это сделал бы человек.

- В процессе генерации текста слова из списка вставляют в текст таким образом, чтобы они не нарушали его естественность.

- ИИ-детектор, который знает, какие слова входят в список, анализирует текст. Если значительная часть включает слова из него, сервис делает вывод, что текст сгенерирован.

С методом есть проблемы. Например, список слов может утечь в сеть. А еще стандартизировать такой документ для нейросетей от разных разработчиков сложно, и это требует от частных компаний сотрудничества.