Motion Control в Kling: как перенести движение из видео на своего персонажа

В соцсетях завирусилась функция Motion Control, доступная в сервисе для генерации видео Kling.

На основе изображения персонажа и видеореференса пользователи генерируют ролик, в котором персонаж повторяет движения из исходного видео. Это проще, чем анимировать картинку с нуля, и позволяет передать естественные или сложные движения.

Расскажу, как этот эффект используют для создания ИИ-инфлюенсеров и как сделать свое видео.

Вы узнаете

Как работает функция Motion Control

Motion Control — это способ управлять движением в сгенерированном видео. Вы задаете, как именно должен двигаться персонаж, а модель не придумывает анимацию сама, а повторяет эти движения. Вот как это работает:

- Загружаете изображение персонажа. Это может быть фото человека, нарисованный герой, маскот бренда. Главное, чтобы хорошо было видно лицо.

- Загружаете видео с движением, которое хотите повторить, — например, ролик, где вы что-то показываете на камеру и активно жестикулируете, или трендовый танец из «Тиктока».

- Нейросеть совмещает эти два источника. Получается ролик, как будто вы пересняли исходный клип с другим героем.

При этом переносится рисунок движения: позы, амплитуда, ритм. Мелкие детали нейросеть достраивает сама, поэтому даже с идеальными исходниками иногда появляются артефакты: плавающие пальцы, странные складки одежды, изменение черт лица в динамике.

Если в исходном видео был звук, нейросеть перенесет его и в ваш ролик. Поэтому Motion Control так хорошо подходит для повторений тренда или съемки роликов, в которых не хочется показывать свое настоящее лицо.

Как перенести движение из видео на персонажа с помощью Motion Control в Kling

Самый популярный сервис с функцией Motion Control — Kling AI. Там можно генерировать видео разными способами: по текстовому описанию, картинке или комбинации текста и изображений.

В Т—Ж есть отдельная статья о том, как зарегистрироваться в Kling и начать пользоваться нейросетью. Для начала работы достаточно авторизоваться по адресу электронной почты.

Количество бесплатных кредитов, которые выдает сервис, иногда меняется. На момент написания статьи можно получить 166 кредитов при регистрации, далее 66 в месяц. Затраты на видео с Motion Control зависят от длительности видеообразца: одна секунда — пять кредитов. Обычно обрабатывают ролики продолжительностью от трех до 30 секунд, чаще всего — 8—10 секунд. То есть бесплатно можно сгенерировать один-два коротких ролика в месяц.

Чтобы получить больше попыток, придется оплатить подписку, стоимость которой начинается от 10 $ (776 ₽) в месяц. Нижний уровень дает 660 кредитов в месяц. Оплатить российской картой не выйдет.

Мне не удалось сделать что-либо бесплатно: сервис постоянно писал, что перегружен, и предлагал оформить подписку, чтобы мои запросы обрабатывались. Поэтому пришлось ее оплатить.

Перед началом генерации подготовьте:

- Картинку с персонажем. Она должна быть четкой, а герой — снят тем же планом, что и на видео, например тоже в полный рост или тоже только лицо. Если на картинке больше одного человека, сервис все равно сгенерирует видео, но движения распределяются случайным образом — артефактов будет больше.

- Образец видео — один человек в кадре, без резких скачков камеры и без перекрытий, когда руки исчезают за предметами или закрывают лицо.

Дальше порядок действий такой.

Шаг 1. Откройте раздел Motion Control на сайте Kling или в мобильном приложении.

Шаг 2. Загрузите изображение персонажа. Если в кадре будут руки крупным планом, например в танце или при демонстрации предметов, лучше выбрать картинку уже с руками.

Шаг 3. Загрузите видео с образцом движения или выберите понравившееся из библиотеки на сайте. Если планируете потом смонтировать длинный ролик, начните с короткого фрагмента с самыми важными движениями: так проще отлавливать ошибки.

Шаг 4. Выберите настройки. Под полями для картинки и видеообразца есть переключатели:

- Character Orientation Matches Video — выбирайте этот вариант, если персонаж должен быть в полный рост и выполнять активные движения, например танцевать. В этом случае приоритетнее движение и позы.

- Character Orientation Matches Image — выбирайте этот вариант, если вы загрузили портрет или будете копировать простое движение. Так лицо будет переноситься точнее.

Внизу есть переключатель для аудио: звук из исходного ролика можно сохранить или убрать.

Шаг 5. Напишите промпт на английском языке. Он должен быть коротким и описывать не движение, а сцену: фон, локацию, детали в кадре, освещение. Этот шаг можно и пропустить.

Вот несколько вариантов:

- универсальный промпт — realistic video, indoor, soft daylight, clean background, cinematic lighting, high detail;

- тренд в соцсети — phone camera style, casual vlog, natural skin texture;

- любительское летнее видео — live stream scene, summer vibe;

- немного ночного мегаполиса — neon city street at night, cinematic lighting;

- съемка на кухне — cozy kitchen, warm light, vlog style;

- демонстрация устройства — minimal white backdrop, product demo, ad style.

Шаг 6. Нажмите Generate, подождите несколько минут и скачайте результат — только само сгенерированное видео или вместе с исходниками в одном кадре.

Я сгенерировала фото девушки в полный рост в Nano Banana Pro и там же попросила нейросеть создать фото с других ракурсов — чтобы девушка сидела за столом и смотрела прямо в камеру. Затем с Kling Motion Control сделала два видео с этим персонажем.

На первом видео девушка повторяет танец из шаблонов Kling. Звук, движения, мимика перенесены оттуда. Получилось весьма реалистично, даже проходящие мимо люди все-таки идут. Но в целом надежнее анимировать картинки, где других персонажей нет: так будет меньше ошибок.

Для второго видео я взяла начало ролика из «Тиктока» и перенесла его вместе со звуком. Соответственно, слова, мимика и движение губ тоже были скопированы — и сгенерированная девушка заговорила на камеру с естественными интонациями.

Правда, генерацию можно распознать по странному движению рук.

Шаг 7. Опциональный. Если голос на видео по каким-то параметрам не подходит новому персонажу и вы хотите его изменить, извлеките аудиодорожку из получившегося ролика и загрузите ее в раздел Voice Changer в сервисе ElevenLabs. Выберите подходящий голос, переозвучьте ролик и смонтируйте его с новой аудиодорожкой. В другом тексте мы подробно рассказывали о том, как пользоваться Elevenlabs.

Где еще можно перенести движение с видео

Кроме самого Kling функцию Motion Control можно попробовать и в других сервисах.

Higgsfield — агрегатор нейросетей с доступом к Kling Motion Control. С бесплатным планом дают 15 кредитов, одна генерация стоит три кредита, так что получится сгенерировать пять роликов.

Freepik — еще один популярный агрегатор с доступом к множеству нейросетей. Генерация в Kling Motion Control доступна только по подписке, самый недорогой план стоит 3,75 € (340 ₽) в месяц.

Wan 2.2 Animate — более старая модель, чем Kling. Тут важно, чтобы исходная картинка была чистой — без лишних людей и с точно такими же пропорциями, что и в референсном видео.

Этот сервис генерирует в двух режимах. Move переносит движение персонажа из видео в новую сцену. Подходит, если нужно изменить и персонажа, и окружение. Replace заменяет только персонажа в видео и сохраняет остальную сцену без изменений. Бесплатно дают 25 кредитов, а генерация стоит 250, так что понадобится подписка, которая стоит от 30 $ (2 323 ₽) в месяц.

Почему Motion Control вызвала дискуссии о рисках и фейках

Копирование движения и мимики стало предельно простым. Формат идеально подходит для платформ с короткими видео, где многие тренды строятся на повторении одинаковых танцев или движений. А еще это позволяет делать эффектные ролики в пару кликов.

У этого есть и риски. О Motion Control заговорили не как о красивом эффекте, а как о дешевом способе подмены личности в интернете. Пока заметны не все угрозы, которые это несет, но несколько серьезных изменений уже обсуждают.

📹 ИИ-инфлюенсеры. Персонаж, который может выпускать ролики без сложных съемок и монтажа, — привлекательная возможность для брендов и блогеров с постоянной аудиторией. Можно быстро локализовать контент, тестировать подачу и повышать свою узнаваемость.

Проблема в том, что снижается доверие к видео как к доказательству подлинности. Любимый блогер на самом деле может быть фермой из недорогих гаджетов, копирующих движения с одного образца на разных персонажей. А нишу типовых роликов вместо живых инфлюенсеров могут занять сгенерированные: простые объяснения, демонстрацию товаров и их использование уже реально просто повторять.

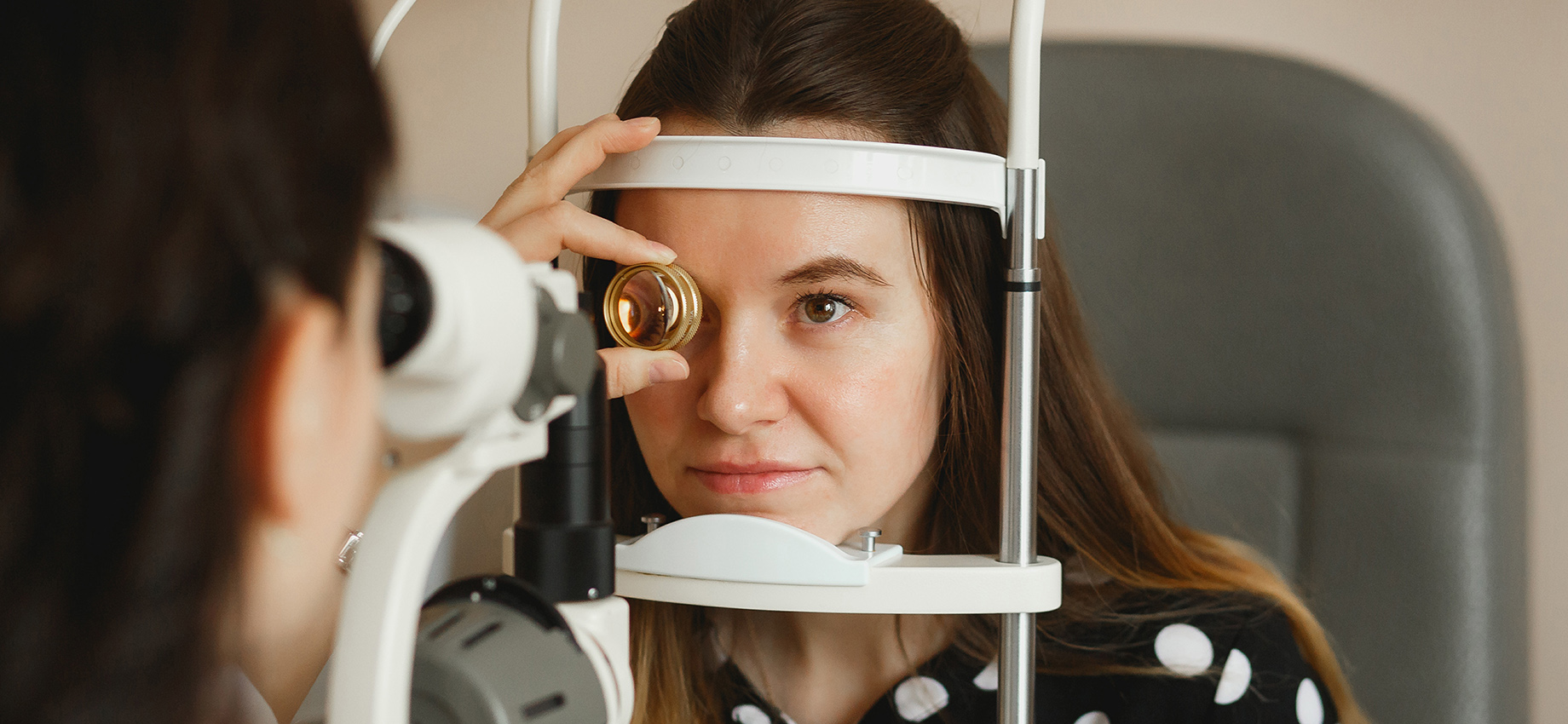

🛂 Проверка личности. Еще более напряженная дискуссия ведется вокруг удаленной верификации личности. Обычно пользователя или нового сотрудника просят включить веб-камеру, улыбнуться, покрутить головой влево-вправо. Этот способ проверки используют в некоторых банках, в основном зарубежных, при приеме на работу дистанционно и при регистрации в сервисах. С Motion Control такое видео можно сделать за несколько минут, имея настоящее или сгенерированное фото и видеоролик с движениями для образца.

Большие сервисы уже ввели дополнительные слои проверок: одиночных жестов теперь недостаточно, к тому же системы стали бороться с подменой видеопотока с камеры на заранее сгенерированный.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult