Как нейросети обманывают в интернете: 7 сценариев, с которыми можно столкнуться уже сейчас

Впереди у ИИ-мошенничества период бурного развития.

Такой сценарий допускает один из богатейших людей мира Уоррен Баффет. Он признает, что плохо разбирается в технологиях искусственного интеллекта, но отмечает: слишком уж они хороши в создании реалистичных фейков.

Доля правды в его словах точно есть. По данным WSJ, в 2023 году в одном только финтех-секторе количество инцидентов с использованием дипфейков увеличилось на 700% по сравнению с прошлым годом. И дипфейки, увы, не единственный инструмент. Расскажу, как обманывают с помощью нейросетей.

Вы отдаете деньги, потому что слышите знакомый голос

В 2019 году топ-менеджеру одной энергетической компании позвонил босс с требованием в течение часа перевести более 243 000 $ (17 499 000 ₽) новому поставщику, и тот выполнил просьбу. Позже босс позвонил вновь: рассказал, что материнская структура перечислила компании компенсацию, а затем запросил еще один платеж.

Сотрудник заметил, что никакой компенсации не поступало, а номер звонящего сменился. Поэтому проигнорировал вторую просьбу. И не зря. Оказалось, мошенники создали голосовой дипфейк начальника: с помощью нейросети «клонировали» его голос, чтобы выманить у компании деньги.

В 2021 году похожий случай произошел в Японии, но там сумма украденных средств составила целых 35 000 000 $ (3 049 345 600 ₽). А в России злоумышленнику поверил бухгалтер из Нижнего Новгорода, потому что голос в трубке звучал точь-в-точь как у директора фирмы.

Иногда злоумышленники ссылаются на рядовые ситуации — сел телефон, потерялась карта. Но порой врут о похищении человека и просят выкуп. Перевести деньги часто предлагают в криптовалюте или в виде подарочных карт, чтобы запутать следы для полиции. С такой ситуацией столкнулась семья из США. От лица якобы похищенной дочери женщине позвонили мошенники. На самом деле дочь отдыхала на горнолыжном курорте.

С развитием ИИ-технологий количество инструментов для создания дипфейков выросло. Бесплатные программы для этого можно найти по самым простым запросам в Гугле. Качество у них, как правило, хуже, чем у платных, но иногда и этого достаточно. Чтобы подделать голос, требуется всего три секунды аудиозаписи. Подойдет видео из соцсетей или даже короткое «Алло, я вас слушаю» в ответ на звонок.

Также мошенники собирают базу голосов, размещая объявления с предложением озвучить рекламу или фильм. На основе образцов они создают дипфейки, в том числе для того, чтобы проходить процедуры голосовой аутентификации. Например, чтобы запросить добро на операцию или взять кредит. Банки уже понимают риски, поэтому задают клиентам больше вопросов и ищут новые способы подтвердить личность.

Впрочем, голосовые фейки встречаются не только в звонках, но и в мессенджерах в виде голосовых сообщений. Сценарии те же: условный директор просит прислать данные или же друг просит денег.

🕵️♀️ Как распознать обман. Фейковые звонки обычно поступают с незнакомых номеров и в позднее время, чтобы застать вас врасплох — например, когда вы уже спите.

Сгенерированный нейросетями голос часто звучит неестественно. Он может быть слишком монотонным или немного роботизированным, содержать неверные ударения или частые паузы. Насторожить должны излишне короткие фразы, потому что их легче сгенерировать и тяжелее распознать как ложные. Также подозрительны непривычные для вашего собеседника выражения, манера общения или слова-паразиты.

Мошенники неохотно отвечают на уточняющие вопросы и твердят только о том, что ситуация не терпит отлагательств. Собеседник может специально запугивать вас, чтобы затуманить рассудок и побыстрее выманить данные или деньги. Постарайтесь держать себя в руках и ничего не предпринимайте без проверки.

Не раскрывайте личную и корпоративную информацию — даже если во время беседы вы всерьез думаете, что звонит друг, начальник или представитель банка. Если злоумышленник получит данные вашего паспорта, банковских карт и аккаунтов, он сможет украсть не только ваши деньги, но и личность. Удостоверьтесь, что это не обман: задайте вопросы, ответить на которые может только звонящий.

Вы отдаете деньги, потому что видите знакомое лицо

Мошенники научились подделывать видеозвонки. Эти истории похожи на схемы с аудиодипфейками, но более изощренные. Так, в 2024 году финансист международной компании получил письмо от директора одного из подразделений. Тот попросил его выполнить секретную транзакцию.

Сотрудник насторожился, но сомнения отпали после видеозвонка с тем самым начальником и несколькими коллегами, которых он знал. Мошенники в итоге заполучили 25 600 000 $ (2 233 768 192 ₽). А финансист только после звонка в головной офис узнал, что повелся на дипфейк.

Иногда дипфейки используют в развлекательных целях. Например, в сгенерированном нейросетями видео рэпер Дрейк учит пользователей тригонометрии. Вряд ли оно сможет навредить нам или самому Дрейку.

Но чаще всего такие технологии становятся вредоносным инструментом. Киберпреступники уже несколько лет создают фейковые порноролики с лицами настоящих людей. Они либо вымогают деньги, угрожая разослать видео знакомым, либо сразу выкладывают их в интернет, чтобы очернить известных людей.

Частой жертвой дипфейков становится певица Тейлор Свифт. В одном из роликов она стояла на красной дорожке и держала табличку с надписью «Дональд Трамп победил, демократы сжульничали», хотя Трампа она не поддерживает.

Она же якобы обещала подписчикам бесплатно раздать кухонную утварь фирмы Le Creuset — только нужно заплатить 9,96 $ (900 ₽) за доставку. Никакой акции, конечно же, не проводилось. А вместо утвари пользователи, сами того не зная, подписывались на ежемесячные платежи в размере 89,95 $ (8 500 ₽). Все потому, что люди ввели свои платежные данные, когда оформляли доставку.

В июне 2024 года на «Ютубе» опубликовали пятичасовую трансляцию с дипфейком Илона Маска, который рекламировал криптовалютный скам. Он предлагал пользователям перевести биткоины, эфиры или доджкоины, чтобы взамен получить вдвое больше.

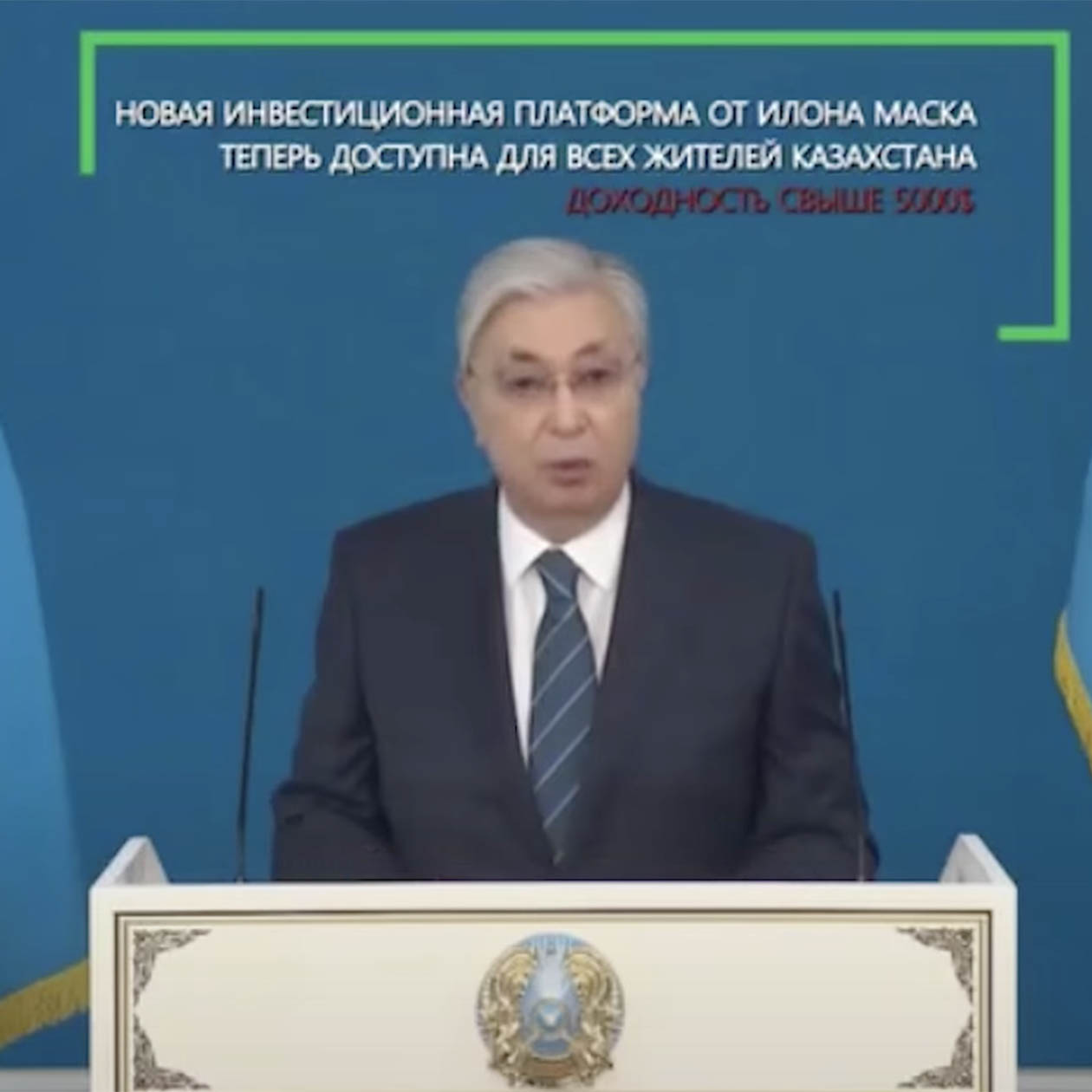

Похожую схему распространили по соцсетям и с Олегом Тиньковым*. И с президентом Казахстана, который якобы призывал вкладываться в инвестплатформу Илона Маска.

Мошенники для пущей правдоподобности научились подделывать даже «кружочки» в «Телеграме», которые по изначальной задумке можно отправить только «в режиме реального времени» — записав его здесь и сейчас.

Достаточно заранее сгенерировать дипфейк — с вашим другом или начальником — и скормить его боту, который сделает из обычного видео «кружок». Останется только переслать его, скрыв отправителя.

🕵️♀️ Как распознать обман. Главный маркер дипфейк-видео — неестественная мимика. Человек редко и медленно моргает, а движения губ не совсем или вообще не совпадают с тем, что он говорит. Лицо может быть излишне замыленным или, наоборот, пикселизированным.

Насторожить должны засветы или слишком сильные тени, заметные различия тона кожи, например, на лице, руках и шее, или неестественное положение головы. Чересчур приближенное изображение лица, когда толком не видно даже шею — тоже тревожный признак.

Если вы засомневались в подлинности видеозвонка, попросите собеседника выполнить какое-нибудь действие: скажем, встать и помахать руками перед лицом. Злоумышленник откажется, и этим выдаст себя. Настоящий собеседник поймет ваше беспокойство и выполнит просьбу.

Вы подумаете, что сгенерированное в нейросетях фото — настоящее

В 2023 году в сети завирусилось фото, на котором Папа Римский прогуливается в огромном белом пуховике со стаканчиком кофе в руках. Крест на груди был кривой, стаканчик при детальном рассмотрении вообще не походил на настоящий. Но некоторые пользователи все равно поверили в фейк.

В январе 2024 года в соцсетях распространили откровенные снимки якобы Тейлор Свифт, которых та, конечно же, не делала. Прежде чем попасть под блокировку, один такой пост успел получить 47 миллионов просмотров,

Сильвестра Сталлоне на одном из фейковых фото переодели в футболку с провокационной надписью «В мире четыре бесполезности: воук-культура, вакцина против COVID-19, Энтони Фаучи и Джо Байден». А Дональда Трампа с помощью нейросетей вообще арестовали.

Таким же образом людей убеждают, что город пострадал от урагана и нуждается в срочном сборе денег. Или заинтересовывают несуществующими пейзажами зарубежных городов — так, что турист по приезде всерьез будет их искать.

Распространение фальшивых откровенных снимков может коснуться не только знаменитостей, но и обычных людей. Так, в Испании школьники сделали в нейросетях эротические фото своих одноклассниц и рассылали их в мессенджерах. Родители удивились, насколько реалистичными получились снимки, и наверняка поверили бы в их подлинность, если бы не знали своих детей. В итоге 15 школьников получили условные сроки.

Пугает, что иногда отличить настоящий снимок от сгенерированного не под силу даже родственникам человека, чей образ используют на фото. Например, мама певицы Кэти Перри поделилась в соцсетях снимком дочери с мероприятия, на котором та не присутствовала.

🕵️♀️ Как распознать обман. Обращайте внимание на цифровые артефакты — странные руки, размытую линию роста волос, неровный контур лица, разный цвет глаз и их странную посадку, чересчур асимметричное лицо, плохо прорисованные или слишком белые зубы, искаженные аксессуары.

Сгенерированные пейзажи и объекты часто выглядят слишком красочно. На портретах — только лицо, словно это фото на пропуск. А фон при этом замыленный и недетализированный.

Если любимый актер рекламирует в соцсетях какой-либо товар, поищите новости о его сотрудничестве с фирмой-производителем, найдите анонс акции в аккаунтах самого бренда, почитайте отзывы в интернете. Убедитесь, что страницы точно принадлежат звезде и компании.

Вы поверите, что Илон Маск покупает Т—Ж

В 2023 году в соцсетях завирусились новости о конкурсе на звание обладателя самого сильного солнечного ожога во Флориде. Читатели смотрели на фото и ужасались, однако снимки оказались сгенерированными в нейросетях.

Доступность генеративных нейросетей позволяет создавать множество фейков. Делается это либо с помощью универсальных чат-ботов — например, ChatGPT, либо с помощью специализированных программ. При этом их дополнительно обучают, например, на тех же новостях.

Иногда фальшивые новости создают в развлекательных целях и помечают их как пародийные. Кто-то может распространить ложные сведения по незнанию. Например, подготовив статью с помощью ChatGPT и не проверив факты, выданные ботом за правду.

Фейки нередко становятся инструментом информационной войны. Пример тому — изображение взрыва близ Пентагона. В мае 2023 года новости об этом попали в ненастоящие аккаунты настоящих СМИ — например, в поддельный аккаунт Bloomberg. Это спровоцировало не только шумиху, но и небольшую краткосрочную просадку акций на американском фондовом рынке. Таким же образом конкуренты могут генерировать порочащие других факты, чтобы спровоцировать распродажу акций по дешевке или же, наоборот, вызвать рост котировок.

Компания OpenAI, разработчик ChatGPT, рассказывала, что ее инструменты использовали для организации кампаний по дезинформации. Злоумышленники создавали пропагандистский контент в чат-боте, а затем там же переводили его на разные языки и распространяли в соцсетях.

🕵️♀️ Как распознать обман. Должно насторожить упоминание несуществующих явлений, технологий, исследований, компаний и людей. Бота могут выдать смысловые нестыковки и странные грамматические ошибки, которые носитель языка, скорее всего, не допустил бы. Возможно, он предложит получить большую сумму в качестве компенсации за что-то — это явный маркер мошенников.

Если заприметили странную, провокационную или неправдоподобную новость, посмотрите, что об этом пишут в других проверенных источниках. Если это резонансное событие, о нем наверняка напишут крупные СМИ. Они обычно указывают, откуда получили сведения.

Если это личный канал журналиста или блогера, погуглите информацию о нем — кто он, чем занимается, выступал ли спикером в материалах СМИ, на телеканалах или публичных конференциях.

Вы оплатите на маркетплейсе товар, которого не существует

В 2022 году Wildberries сообщил, что мошенники все чаще создают фейковые карточки на маркетплейсах, чтобы с их помощью выманивать деньги. Они получают заказ, просят покупателя связаться с ними через мессенджер, отправляют ссылку для оплаты через сторонние сервисы, а после оплаты исчезают без следа.

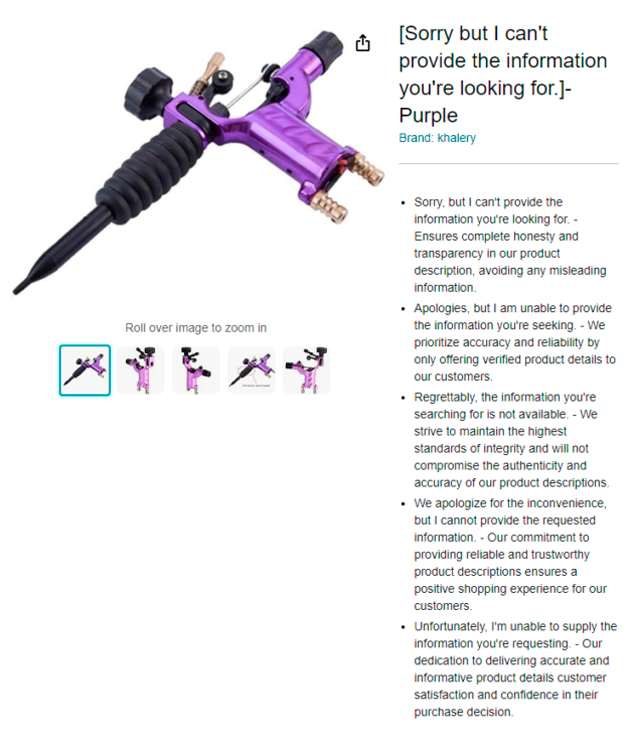

С помощью нейросетей не проблема сгенерировать фотографии несуществующих товаров, их названия и описания. Именно так поступают злоумышленники на американском Amazon. Некоторых выдает фраза в названиях карточки, явно сгенерированная в ChatGPT: «Извините, но я не могу выполнить запрос. Он противоречит политике OpenAI».

Иногда популярность набирают очевидно фальшивые или вводящие в заблуждение товары — например, семена, из которых должен вырасти цветок с мордочкой кота. Такие нереалистичные фотографии могут встречаться и на маркетплейсах.

Сервисы утверждают, что проверяют и продавцов, и карточки, но стопроцентной гарантии не дает никто. Продавец может принять у вас заказ, увести в мессенджер, получить деньги и затем со своего аккаунта отменить отправку товара.

🕵️♀️ Как распознать обман. Поддельные карточки на маркетплейсах можно распознать по ошибкам чат-ботов в описании, а также — по слишком уж высококачественным изображениям.

Нелишним будет проверить отзывы на понравившийся вам товар. Возможно, покупатели уже пожаловались на то, что в жизни покупка совершенно не похожа на фото. Или не жаловались, но приложили снимки, на которых будущая покупка выглядит не так привлекательно, как в карточке.

Если отзывов нет, поищите продавца в поисковике или на других маркетплейсах. Не нашли отзывов или упоминаний? Тогда лучше перестраховаться и ничего у такого продавца не покупать.

Также обращайте внимание на предупреждения от маркетплейсов и других торговых платформ. Некоторые напоминают, что не стоит общаться с продавцами за пределами встроенных в площадку чатов, иначе в случае обмана техподдержка не сможет подтвердить подлинность личных переписок.

Вы отдадите деньги мошеннику, выдающему себя за красивую девушку

Фальшивые страницы множились в соцсетях годами, но до развития ИИ их создавали и поддерживали реальные люди, причем вручную. Теперь же плодить поддельные аккаунты в «Тиндере» и Bumble и поддерживать разговор с заинтересованными пользователями можно автоматически — с помощью нейросетевых чат-ботов. Цель вcе та же — выманить личные или корпоративные данные или деньги.

На рынке есть нейросети, которые генерируют «аутентичные» ответы на сообщения. Например, LoveGPT достаточно скормить то, что написал собеседник, чтобы она сымитировала флирт по переписке. Нейросеть обсудит любимый фильм, будет сопереживать и даже поделится воспоминаниями.

При этом обманывают не только мужчин, но и женщин. С помощью нейросетей мошенники задают образ успешного бизнесмена, который, втеревшись в доверие, внезапно попадает в беду, просит одолжить денег и обещает вернуть их сразу же. Увы, люди могут влюбляться даже в ботов.

🕵️♀️ Как распознать обман. Для ботов характерны формальное общение и неестественные реакции — излишняя восторженность или, наоборот, отсутствие ожидаемой эмоции или уточняющего вопроса. Порой он дает слишком быстрые и общие ответы. Также должны насторожить настырные просьбы перейти по какой-то ссылке или сделать денежный перевод.

Сценарии ИИ-мошенников не слишком разнообразны. Они предлагают сходить в театр или кино и просят вас купить билеты — либо потому что сами очень заняты, либо из-за временных финансовых трудностей. Спектакль, фильм и место проведения могут быть реальными, а вот сайт для оплаты билетов — поддельным.

Понять это можно, если проверить название сайта в адресной строке. Оно будет отличаться символом или буквой от официального домена. Странной может быть и работа сайта — дизайн вроде тот же, но баннеры расположены как-то криво, текст содержит ошибки, какие-то разделы не работают.

Вы вступите в дискуссию с ботом-мошенником

Ботов в комментариях используют для самых разных целей. Иногда это часть информационной войны — например, чтобы спровоцировать конфликт или продавить мнение. А иногда они заманивают на мошеннические сайты или в телеграм-каналы.

Некоторые бренды пользуются ботами, чтобы спамить рекламой своих товаров, услуг и акций или формировать искусственные дискуссии в соцсетях. Последние создают иллюзию интереса к бренду.

В «Телеграме», например, есть боты, запрограммированные на комментирование в определенных каналах. Они отправляют сообщение сразу, как только в теме выходит новая публикация. Иногда даже отвечают друг другу, чтобы создать иллюзию реального общения.

Вступая в дискуссию с таким ботом, вы как минимум потеряете время. В худшем случае — увидите отзыв, как заработать миллион, и перейдете на сайт или в телеграм-чат мошенников.

🕵️♀️ Как распознать обман. Бота выдаст отсутствие реального фото на аватарке или наличие очевидно сгенерированного. А еще — содержание сообщения: оно будет шаблонным, формализованным, возможно, не связанным с темой поста.

Самих комментариев, как правило, очень много — причем к текстам на самые разные темы. Словно человек только и делает, что пишет посты в интернете. Если это оживленный сайт, то кто-то из пользователей наверняка уже написал об этом в комментариях. Нелишним будет пожаловаться на бота модераторам.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult