Как мы использовали нейросети в рекламе и увеличили показатели за месяц в пять раз

В Т—Ж уже несколько месяцев продолжается эксперимент: для некоторых статей обложки генерируют в нейросетях.

Они достаточно просты в использовании — можно с ходу создавать сносные проработанные изображения. Но действительно качественные генерации получаются не сразу: нейросеть нужно тщательно настроить под свои запросы, в идеале — дообучить. Иначе получится не то, что нужно, а скорее неконтролируемая фантазия на тему.

Первые наши обложки получились крайне удачными — их можно увидеть в материалах о бизнесе и психологии.

Поэтому мы решили провести эксперимент: сделать несколько рекламных плакатов для курсов Учебника Т—Ж и посмотреть, что сработает лучше всего.

Спойлер: победило аниме.

Какую нейросеть мы выбрали

В генерации обложек мы пробовали разные модели. Например, есть Midjourney — довольно простая в использовании нейросеть. Она генерирует красочные изображения по простым запросам, и для нее не нужен мощный компьютер: картинки создаются на серверах разработчиков.

Так что Midjourney — это хорошая точка вхождения для тех, кто до этого с нейросетями вообще никак не работал. Но она платная, а ее возможности ограничены.

В других случаях пробовали Stable Diffusion. На данный момент это самая продвинутая нейросеть для генерации картинок. В ней можно создавать качественные изображения с детальной настройкой практически всего, а еще она полностью бесплатна.

К тому же открытый исходный код позволяет дообучать Stable Diffusion на своих картинках. Но для нее нужен мощный компьютер и время, чтобы разобраться во всех тонкостях. Придется потратить немало времени на гайды.

Мы выбрали как раз Stable Diffusion. У этой нейросети сейчас есть ограничения, которые надо учитывать: нельзя сгенерировать текст на иллюстрациях или сложные объекты вроде купюр. Лучше всего получается стилизация.

Как нейросеть может пригодиться в рекламе

Возникла идея — использовать Stable Diffusion для A/B-тестирований. Это такие маркетинговые исследования, которые помогают на практике проверить, какая реклама лучше себя показала.

В нашем случае это работало так. Мы создавали разные визуализации одного и того же баннера, а затем запускали рекламу. После смотрели, какой баннер сработал лучше всех, и делали для него еще несколько вариаций. И повторяли этот цикл до тех пор, пока не получали нужных нам показателей переходов по рекламе.

Мы в Учебнике Т—Ж рекламируем самые разные курсы, и для каждого нужен свой подход. Без нейросетей A/B-тестирование подразумевало постоянное вовлечение дизайнеров. Но они тоже живые люди и не могут делать по десять иллюстраций за день — особенно когда речь о детализированных картинках в самых разных стилях.

Нейросети решают эту проблему: можно в течение дня сгенерировать десять уникальных картинок, на которые человек потратил бы больше недели.

Если иллюстратор сделает рисунок в стиле аниме день, то предварительно подготовленная нейросеть справится за три секунды. Здесь особенно хорошо помогает такая фишка, как дообучение моделей.

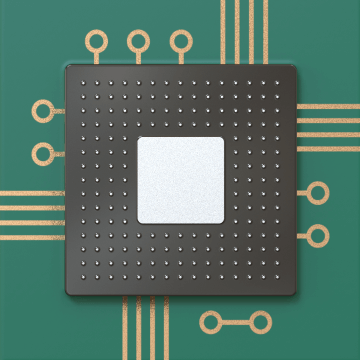

Как устроена Stable Diffusion

Stable Diffusion — нейросеть с открытым исходным кодом, которая появилась летом 2022 года. Поначалу у нее даже не было удобных «оболочек», то есть ее нельзя было запустить как любую другую программу с интерфейсом, приходилось работать через командную строку. Сейчас все стало намного проще.

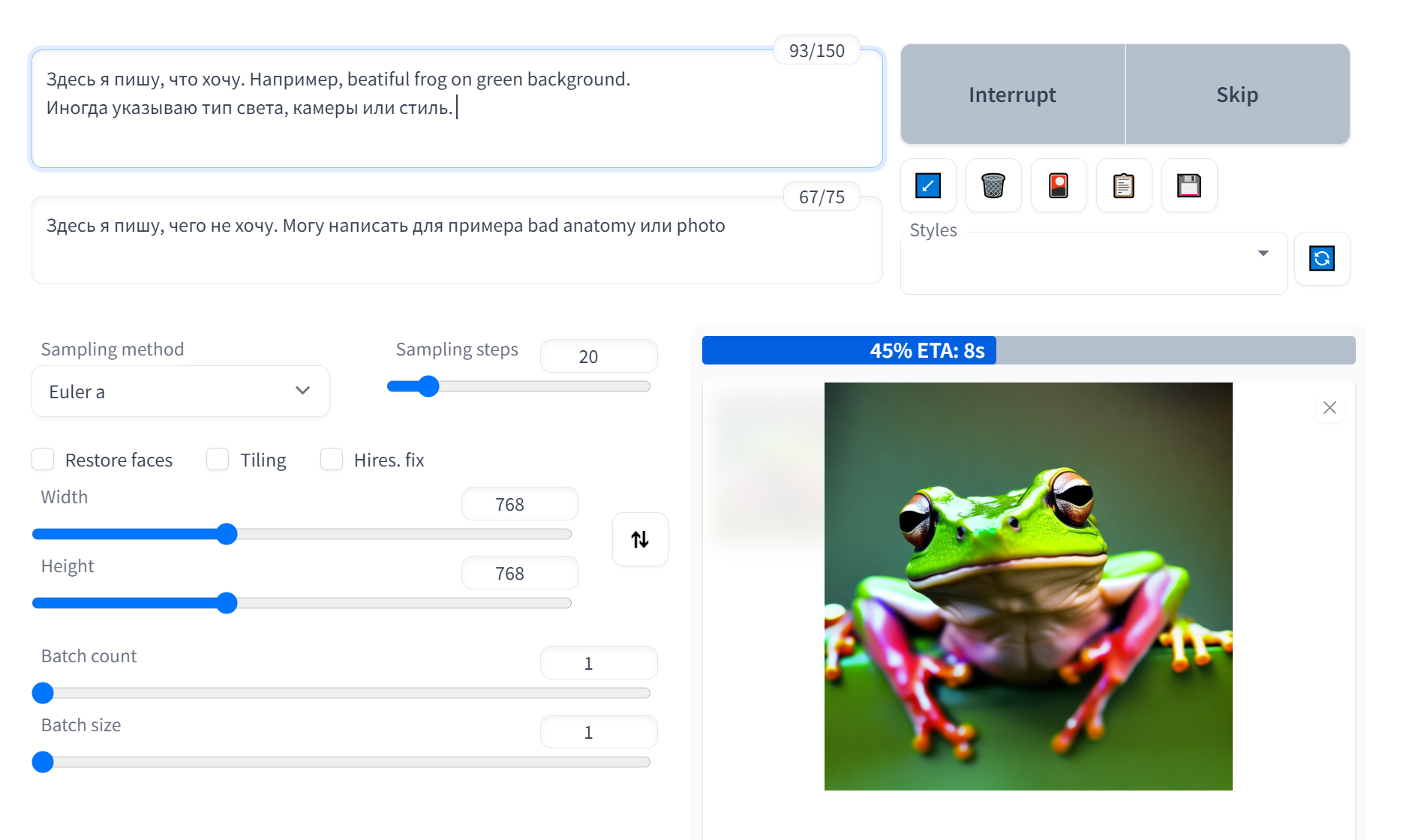

Например, вот так выглядит интерфейс Stable Diffusion. Настроек много, но основная работа идет с запросом — промтом. Есть два поля для текста: в первом — что хочешь получить, во втором — чего не должно быть в генерации.

Важное преимущество Stable Diffusion в том, что модель можно дообучить на собственном наборе картинок, или датасете. Изначально нейросеть уже обучена на тысячах других изображений, но если хочется добиться определенной стилизации, придется создавать свои модели с датасетами.

В интернете можно найти пользовательские модели. Среди них есть 3D, винтажные кадры, вышивка, классическая анимация и даже безумный вариант на основе Liquid Television с MTV — передачи, где транслировали андеграундные мультфильмы и анимацию.

Мы тестировали десятки разных моделей, чтобы плакаты для баннера были разнообразнее. Но на этом не остановились и сами обучили три модели: на простых иллюстрациях, кадрах с «Пинтереста» и экспериментальной живописи.

Дообучение одной модели на ноутбуке с видеокартой 3080 RTX 16 Gb занимает полтора часа. Еще пару часов — подготовка датасета из 40 изображений. Несколько моделей получились неудачными: векторные иллюстрации генерировались плохо. А однажды Stable Diffusion выдал ошибку и заставил почти что рыдать. Модель полтора часа дообучалась, надо было использовать день в день, а в итоге ничего не сработало. Стоило запустить обучение заново — все стало хорошо. Но времени потеряли прилично.

Всего с начала эксперимента мы использовали 12 разных моделей.

Какие у нас получились баннеры

Мы не получали готовых изображений с первых же запросов. Сначала генерировали от 5 до 10 квадратных иллюстраций, а затем растягивали их до вертикального формата так, чтобы сохранить композицию. Исправляли недостатки: ошибки в анатомии, негармоничные цвета или артефакты. Склеивали варианты, которые хорошо сочетались.

В целом для одной хорошей иллюстрации мы генерировали 30—100 картинок — это занимало около получаса. Но чем дальше, тем легче. Больше всего времени уходит на поиск идей, поэтому иногда мы отказывались от образов, которые сложно генерировать, или же уходили совсем в другую сторону.

Еще мы использовали img2img, чтобы добавить текст или сложные объекты. Это метод, при котором нейросеть обрабатывает другое изображение. Например, с ним можно загрузить фотографию кота, выставить коэффициент изменения и написать, что нужно сгенерировать, скажем, рисунок на бумаге. И получится тот же самый кот, но будто нарисованный от руки.

Для img2img мы делали грубые коллажи, а потом загружали их в Stable Diffusion. Так мы получили генерации, которые сложно назвать искусственными.

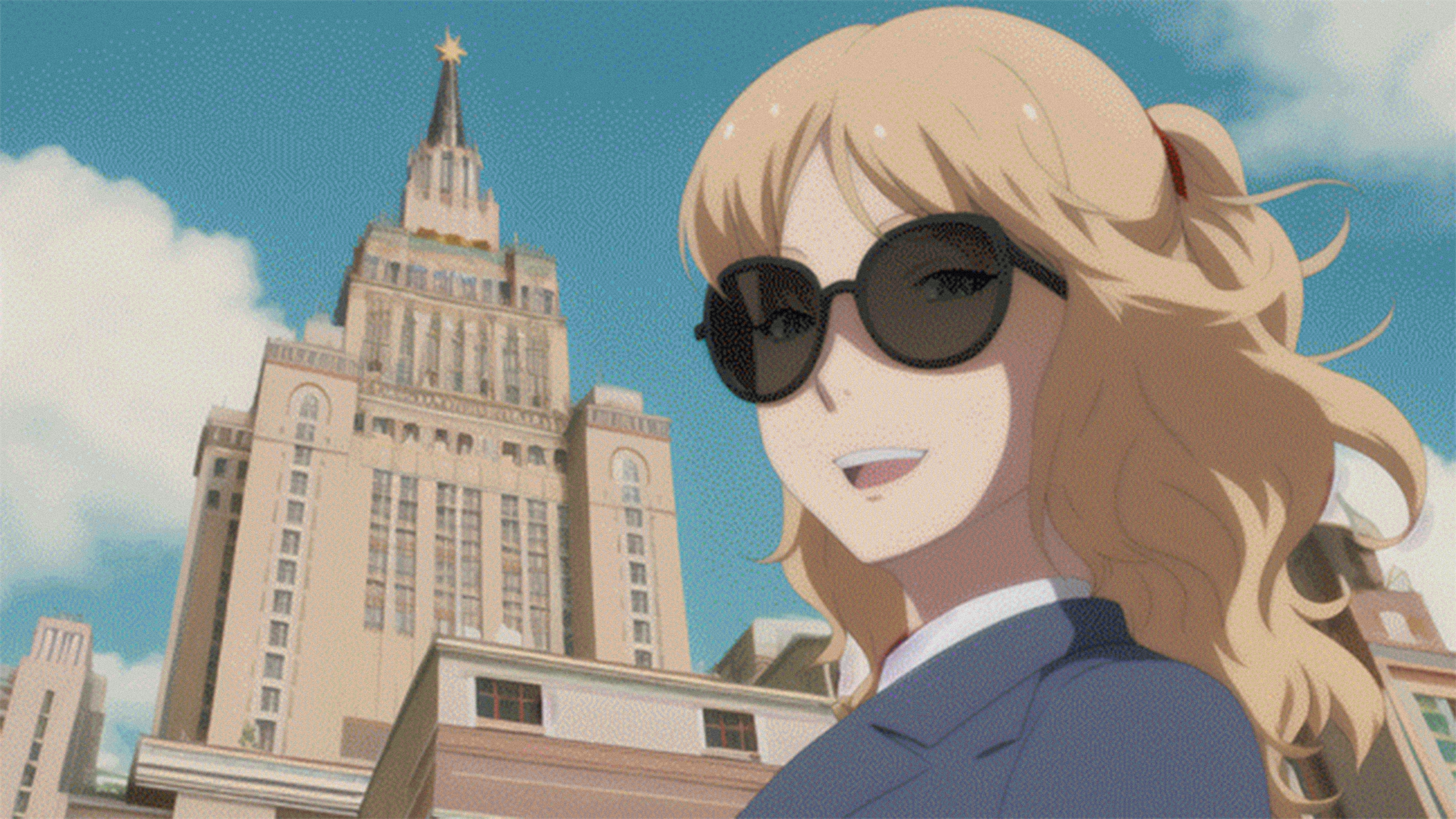

Также задействовали иллюстрации в стилистике аниме. Раньше мы их никогда не использовали, потому что рисовать такое самостоятельно слишком дорого и долго. Интересно, что мы генерировали той моделью, которая, скорее всего, лежит в основе того вирального китайского приложения.

Первые результаты в рекламе

Наши эксперименты с нейросетями мы начали с курса Учебника «Как быть взрослым». Это новый курс, поэтому в январе 2023 года мы поставили себе цель привлечь в пять раз больше студентов, чем в декабре.

В течение нескольких дней мы создали в Stable Diffusion 23 новые визуализации — и сразу же отправили на A/B.

Эксперимент оказался по-настоящему успешным. Изначально мы рассчитывали, что приблизимся к заветным цифрам лишь через три-четыре итерации тестирования. Но нужные нам показатели получились в первой же итерации. Примерно треть баннеров дала нужный нам CTR — это доля кликнувших пользователей от всех тех, кто увидел рекламу. А конверсия оказалась в районе 25—30%.

Топовым баннером оказалась картинка с девушкой в аниме-стиле на фоне здания МГУ. Он сработал в два-три раза эффективнее, чем все остальные баннеры в среднем.

Наши выводы

Мы думаем, что в будущем маркетинг станет работать именно так, но уже полностью автоматизированно. За февраль сгенерировали 46 уникальных плакатов — и без дизайнеров.

Через пять лет концептуальные проблемы диффузионных нейросетей наверняка решат, а это значит, что все больше компаний начнут экспериментировать. Вряд ли дизайнер за день нарисует аниме в стиле студии Гибли или оформит фотореалистичный коллаж под Рене Магритта.

Но нейросети не заменят иллюстраторов. Этот эксперимент был бы невозможен без отбора и доработки. К тому же не получится генерировать баннеры с текстом или самим продуктом — это серьезное ограничение.

По сути, то, чем мы занимались, — наполовину автоматизированное A/B-тестирование. В ходе отбора лучшие иллюстрации показывают себя и самоулучшаются. Если это автоматизировать полностью, то реклама будет все лучше и лучше подстраиваться под целевую аудиторию — сама по себе.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult.